di agrimensore g., con la collaborazione di Fano

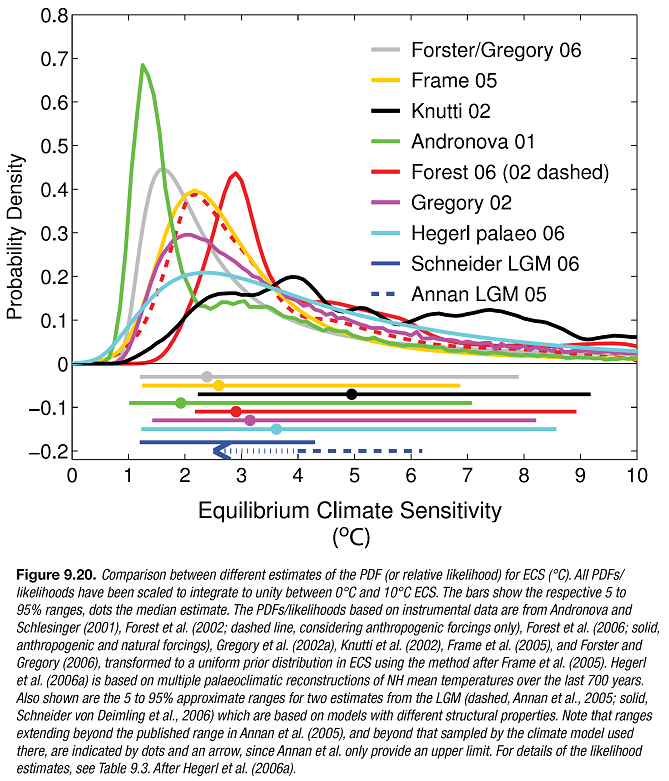

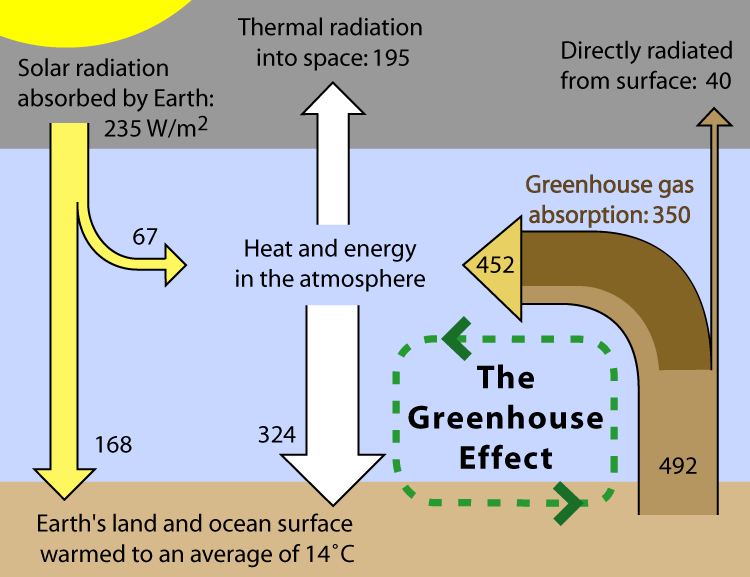

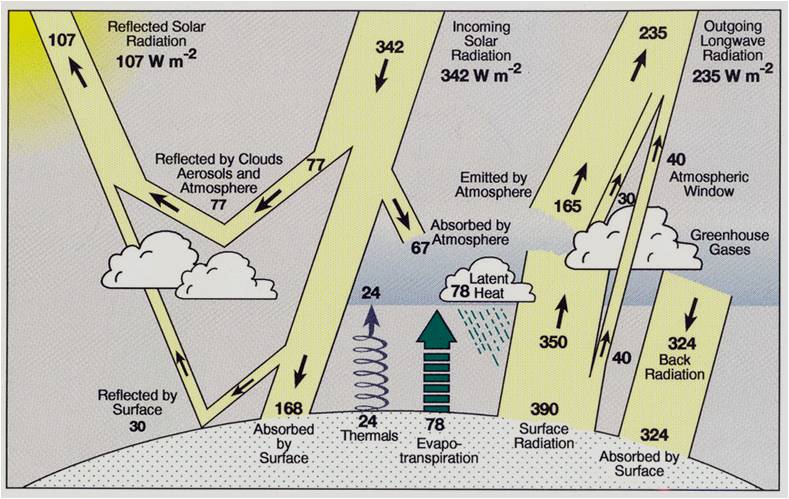

Nella prima parte, abbiamo visto che la stima del valore della climate sensitivity (sensibilità climatica), cioè il coefficiente relativo all’aumento delle temperature a fronte di una maggiore quantità di IR (Infrared radiation), è particolarmente ardua se effettuata confrontando il comportamento della Terra col passato. Quello che si riesce a fare è trovare una funzione di distribuzione del valore che dovrebbe almeno essere sottoposta ad una verifica sperimentale, molto difficile da progettare.

Un metodo alternativo, o a integrazione, è quello di utilizzare i modelli GCM (General Circulation Model)

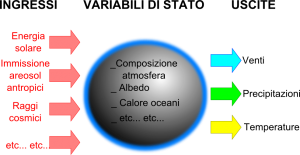

I modelli GCM, come noto, sono quei modelli che prevedono alcune grandezze climatiche (di norma venti, temperature, precipitazioni e pressione) attraverso i relativi valori statistici in un orizzonte temporale di più decadi (venti o trent’anni). In genere le elaborazioni vengono effettuate su potenti computer per permettere il calcolo numeriche delle legge fisiche che interessano il clima.

Funzionano bene?

Il modo più naturale per capire se funzionano è confrontarli con la realtà. Può sembrare una banalità, ma spesso per valutare il loro grado di funzionamento si giudicano le discrepanze tra i vari modelli, il fatto che siano diminuite viene giudicato un buon risultato. Oppure vengono confrontate le medie dei modelli con un super-modello ( http://scienceofdoom.com/2010/03/23/models-on-and-off-the-catwalk-part-two/) per evidenziare come la media sia migliore del singolo.

Mi sembra ovvio che tutto ciò non implichi affatto che i modelli GCM funzionino. Sarebbe opportuno il confronto con la realtà oggetto delle previsioni.

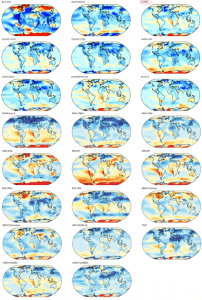

Purtroppo, per riscontrare con gli output dei modelli sarebbe necessario aspettare parecchi anni, perché le loro previsioni si riferiscono a medie e grandezze statistiche da applicare a periodi multidecadali. Anziché attendere venti o più anni, possiamo cominciare a verificare i cosiddetti hindcast, cioè gli output dei modelli che si riferiscono al passato. Riprendo dallo stesso sito precedente, sostenitore dell’AGWT, la figura riportata nell’AR 2007 IPCC in merito ai modelli:

Nelle figura le parti in blu rappresentano una sottostima e le parti in rosso una sovrastima delle temperature. Come si vede non c’è nessun modello che abbia solo colori tenui, chiari. Anche quello che viene considerato il migliore (in alto a destra) presenta vari punti deboli, ad esempio ha sottostimato le temperature in Groenlandia e le ha sovrastimate in Antartide. La circostanza che per qualcuno la media generale sia simile a quella osservata non può essere considerata come la prova che i modelli GCM funzionino.

Prendiamo un’altra grandezza prognostica importante, le precipitazioni.

Qui in generale i modelli GCM sembrano aver sottostimato l’incremento delle precipitazioni avvenuto in questi anni. Lo evidenzia il lavor di Frank J. Wentz, Lucrezia Ricciardulli, Kyle Hilburn, Carl Mears (http://www.remss.com/papers/wentz_science_2007_paper+som.pdf)

con il seguente abstract (già riportato in originale in un precedente articolo di NIA):

Sia i modelli climatici, sia le osservazioni satellitari indicano che la totalità dell’acqua in atmosfera aumenterà del 7% per grado Kelvin di riscaldamento della superficie. Tuttavia, i modelli climatici prevedono che le precipitazioni globali aumenteranno a un tasso molto più lento, da 1 a a 3% per Kelvin (n.d.r: significherebbe più vapor acqueo e meno pioggia). Un’analisi recente delle osservazioni satellitari non conferma questa previsione di una mutata risposta delle precipitazioni a fronte del global warming. Piuttosto, le osservazioni suggeriscono che le precipitazioni e la totalità dell’acqua totale in atmosfera sono aumentate circa dello stesso tasso nelle precedenti due decadi.

D’altra parte, anche le istituzione favorevoli all’AGWT, ammettono che c’è ancora parecchio da sviluppare. Un esempio è contenuto nella lettera (cfr. http://www.aps.org/about/pressreleases/haroldlewis.cfm) con cui l’APS (American Phisycal Society) ha risposto alle critiche del professor Lewis, dimessosi proprio per contrasti in merito alle posizioni dell’associazione sui cambiamenti climatici. Dopo una serie di contestazioni al professore Lewis, l’APS scrive che

However, APS continues to recognize that climate models are far from adequate

Perché i modelli GCM non sono adeguati?

Senza inserire i vari link, è quasi unanimemente riconosciuto che uno dei problemi maggiori dei modelli GCM sia la simulazione del processo di formazioni delle nubi. Questo processo, da un punto di vista algoritmico, è parametrizzato. In sostanza, non è implementato solo attraverso leggi fisiche, ma è stato necessario utilizzare delle formule empiriche che dipendono da alcuni parametri e sono state costruite con algoritmi complessi (es.: reti neurali) cercando di renderle efficaci nel simulare il passato.

Però qualcosa non va.

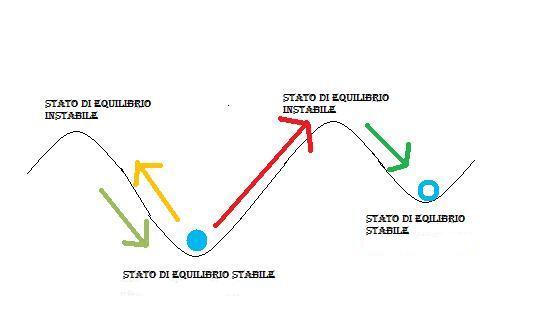

Il processo di formazione delle nubi è importante perché a secondo di come viene implementato può rappresentare un rilevante feed-back positivo o negativo. Secondo una teoria condivisa da molti, almeno quelle medio-basse rappresentano un rilevante feed-back negativo, mentre per molti dei modelli sono un feed-back positivo.

Una possibile spiegazione di questa discrepanza si trova nella teoria di Svensmark e Shaviv circa la capacità dei GCR (Galactic Cosmic Rays) di favorire la formazioni di nubi. L’ingresso dei GCR in atmosfera è modulato dal vento solare; in sostanza, a un’attività solare intensa corrisponde una diminuzione del livello dei GCR, mentre in periodi di scarsa attività solare, i GCR aumentano e di conseguenza si formano più nubi.

Poiché nessun modello GCM considera questa teoria, se essa fosse vera, la parametrizzazione, basata su dati di anni precedenti, avrebbe mascherato la carenza di conoscenza e quindi, la bontà delle proiezioni fornite sarebbe compromessa dal fatto di non aver considerato un input fondamentale. Ovviamente il livello dei GCR in atmosfera è difficilmente prevedibile, cosicché dovrebbe essere incluso come una delle grandezze per definire i vari scenari.

Naturalmente, ci sono altre possibili motivazioni per spiegare la discrepanza tra realtà e proiezioni dei modelli, tuttavia l’elemento più incerto al momento rimane il processo di formazione delle nubi.

Ma i modelli GCM non sono verificati e validati (V&V)?

Si legge e si sente dire spesso che, poiché i modelli GCM riescono a “ricostruire” il clima dell’ultimo secolo, allora possono essere impiegati per provare a prevedere il clima nel futuro. Questa circostanza, comproverebbe che nei GCM sono implementati tutti i processi fisici necessari, inclusi quelli che determinano un aumento delle temperature globali all’aumentare della CO2.

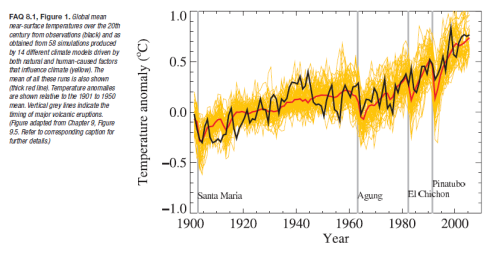

Una prima considerazione è che quanto viene ricostruito dai GCM è il trend crescente della temperatura (a parte le diminuzioni dovute a forte eruzioni vulcaniche), non le oscillazioni di breve periodo, che sono considerate come variabilità interannuali, e quindi pseodocasuali. Però, in questo modo qualunque grandezza abbia avuto un andamento crescente nell’ultimo secolo, e in particolare negli ultimi trent’anni (ad esempio, il debito pubblico italiano), risulterà in correlazione col clima, non solo la CO2, e di conseguenza le temperature ricostruite dai GCM. Per trovare una prova più convincente sarebbe opportuno che i GCM riuscissero a seguire le variazioni del clima (es.: riscaldamento anni ’40), non solo il trend di fondo, corretto col contributo delle eruzioni vulcaniche.

Per chiarire il concetto, esaminiamo la figura che riporta l’IPCC nell’AR 2007

Questo grafico è inteso essere una sorta di validazioni dei modelli perchè si vede che la linea rossa (la ricostruzione media da parte di 14 modelli GCM) segue “piuttosto bene”, la linea nera, ciò che è successo in realtà. Notate però che il “piuttosto bene” è riferito ad un valor medio, mentre le variazioni sono seguite molto bene, solo quando si tratta di eruzioni vulcaniche, e praticamente per nulla negli altri casi. Ad esempio, il riscaldamento avvenuto prima del ’40 non è stato colto dai modelli e nemmeno il raffreddamento nella decade successiva. Certamente si può spiegare quasto scostamento con una variabilità interannuale pseudocasuale. A questo punto, però, se si costruisce un modello facendo dipendere la temperatura da una qualsiasi grandezza che è stata crescente nell’ultimo secolo, e in particolare nelle ultime decadi, ottengo un risultato simile (purchè inserisca la variabile “eruzione vulcanica”). Detta in termini statistici, è l’analisi spettrale quella che più mi convince di aver trovato una buona correlazione. Insomma, come validazione un risultato quale quello esposto in figura non è il massimo, ed oltre tutto si tratta di una media di modelli.

Ma c’è un problema più sottile e decisivo, che si colloca a metà tra l’epistemologia e le tecniche di data mining.

I GCM (così come molti altri tipi di modelli) vengono sviluppati in due fasi:

– la fase di “training” ove il modello “impara” qual è il valore corretto da assegnare ai parametri, a volte con tecniche proprie dell’intelligenza artificiale (la parametrizzazione sopra menzionata);

– la fase di “test” ove il modello viene “collaudato” con dati diversi da quelli utilizzati per la fase di training (backtesting, da cui gli hindcast suddetti).

I dataset utilizzati per le due fasi sono, ovviamente, distinti e si chiamano rispettivamente “training data” e “test data”.

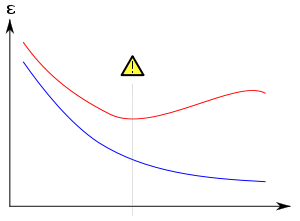

Per capire l’importanza della fase di test, è opportuno ricordare che i modelli, di qualsiasi tipo, debbono affrontare un problema comune: l’overfitting.

Dalla definizione di wikipedia, sappiamo che:

…si parla di overfitting (eccessivo adattamento) quando un modello statistico si adatta ai dati osservati (il campione) usando un numero eccessivo di parametri. Un modello assurdo e sbagliato può adattarsi perfettamente se è abbastanza complesso rispetto alla quantità di dati disponibili.

Overfitting. La curva blu mostra l’andamento dell’errore nel classificare i dati di training, mentre la curva rossa mostra l’errore nel classificare i dati di test o validazione. Se l’errore di validazione aumenta mentre l’errore sui dati di training diminuisce, ciò indica che siamo in presenza di un possibile caso di overfitting.

A tal proposito, rimando al’articolo di Nitopi per la parte matematica propedeutica :http://daltonsminima.altervista.org/?p=12172

L’articolo ci mostra come riusciamo ad approssimare i dati sperimentali rendendo più complicata la funzione, senza però poter affermare di aver migliorato la capacità predittiva della funzione stessa.

E’ un po’ come cercare di insegnare a guidare un ubriaco: durante le guide di prova non va a sbattere perchè l’istruttore prende il volante e frena al posto suo. Però quando è solo, rischia di andare contro un muro o cadere in un fosso alla prima curva.

Ebbene, durante lo sviluppo dei primi modelli GCM, è stato presumibilmente possibile procedere correttamente. I dati a disposizione sono stati suddivisi in “training data” e “test data”.

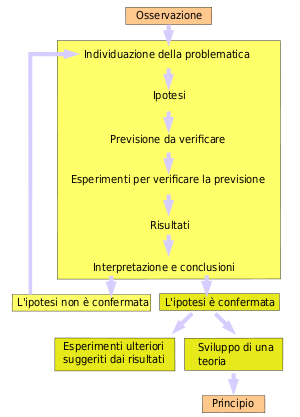

Successivamente, sono stati sviluppati nuovi modelli, a partire, tra l’altro dagli errori riscontrati nei modelli precedenti. Solo che a questo punto tutti i dataset utilizzati dal primo modello, avrebbero dovuto essere riutilizzati come training data, non come test data. Questa criterio deve essere rispettato, altrimenti sarebbe come se le prove sperimentali di una teoria fossero le stesse osservazioni cha hanno indotto la ridefinizione della teoria. Per analogia col metodo scientifico:

1- si fanno delle osservazioni

2- si formula una teoria che le possa spiegare

3- si progetta un esperimento

4- l’esperimento evidenzia delle lacune nella teoria

5- si raffina la teoria

6- si riesegue lo stesso esperimento.

Il punto (6) è sbagliato! Bisogna progettare un nuovo esperimento. Altrimenti abbiamo trovato quella che si definisce una teoria “ad hoc”.

Da qui la domanda conclusiva: da dove sono stati acquisiti i “nuovi” dataset da utilizzare come “test data”, considerato che il modello ha un orizzonte temporale di decenni?

Allora nessun tipo di modello implementato su computer funziona?

I modelli GCM hanno una difficoltà in più rispetto a quelli utilizzati in altre discipline. I loro risultati possono essere verificati solo dopo 20 o 30 anni. Ciò significa che il loro processo di raffinamento è più difficoltoso. Chi lavora nel campo dell’informatica, ha esperienza che persino software molto più semplici, hanno bisogno di essere migliorati dopo la prima istallazione confrontando il loro funzionamento con quanto atteso. Man mano che si scoprono gli errori, il software viene adeguato e funziona meglio.

Dato il vasto orizzonte temporale, questa fase, comune a tutti i modelli, per i GCM è particolarmente complicata. In altri termini, per i GCM, come per tutti i modelli impiegati per previsioni a lungo periodo, è difficile ottenere nuovi dataset utilizzabili come test data. E’ per questo motivo che, ad una prima analisi, appare ancora prematuro pretendere da essi delle previsioni affidabili.

Conclusioni

Abbiamo visto, in questo articolo e nella prima parte, quanto sia arduo fornire una stima della sensibilità climatica e, di conseguenza, come sia azzardato supporre che le stime fornite godano di un elevato livello di confidenza. Quindi non è anti-scientifico, o irrazionale, o ideologico dubitare del livello di confidenza con cui sono presentate le stime sulla sensibilità climatica. Tuttavia, va sottolineato che un ragionamento del genere non è una prova che esse siano errate. Insomma, stiamo affrontando una tematica tecnica, nulla a che vedere con suggerimenti di politiche di riduzione gas serra, valutazione dei rischi, ecc. La critica all’AGWT riguarda principalmente il concetto che il “debate is over” in merito alle previsioni. La conclusione non è un invito ad abbandonare i GCM, ma a continuare a migliorarli, con la consapevolezza che ci potrebbe essere parecchia strada da fare prima di poterli ritenere adeguati allo scopo.