Consideriamo una serie di numeri estratti casualmente, in un intervallo di valori diciamo da 1 a un numero molto grande, diciamo [(10 alla n ) -1 ], poi prendiamo questi numeri e consideriamo solo la prima cifra.

Poiche’ la prima cifra non puo’ essere mai zero, e poiche’ i numeri sono estratti casualmente, la frequenza con cui questa prima cifra sara’ 1 sara’ la stessa con la quale sara’ 2, e cosi’ via fino a 9.

Dunque la frequenza sara’ pari a 1/9 = 0,11 (periodico).

Insomma, ogni cifra da 1 a 9 avra’ l’11,11% (periodico) di probabilita’ di essere la prima cifra di uno di questi numeri.

Nel 1881 l’astronomo americano Simon Newcomb osservo’ uno strano fenomeno, che descrisse nell’American Journal of Mathematic; forse l’aneddoto alla base dell’articolo non e’ vero, comunque e’ plausibile.

Newcomb osservo’ che nella biblioteca universitaria le pagine della tavola dei logaritmi che riportavano i logaritmi di numeri che avevano 1 come prima cifra, erano molto piu’ sporche e usurate delle pagine I cui numeri iniziavano con un altra cifra.

Ne dedusse che, per qualche sconosciuto motivo, venivano consultate piu’ spesso.

Ma gli fu controribattuto che in qualsiasi libro al quale si accede alle pagine in modo sequenziale le prime sarebbero state più usate delle ultime (ovviamente nelle tavole dei logaritmi nelle prime pagine I numeri iniziano per 1, nessuno stampa delle tavole dei logaritmi “random” 🙂 ).

Nel 1938 il fisico Frank Benford analizzo’ molte distribuzioni empiriche di dati, e cosi’ gli venne attribuita la legge che porta il suo nome e che dice, piu’ o meno:

In una raccolta di dati reali, la probabilita’ che la cifra x sia la prima cifra del numero che costituisce il singolo dato, e’ pari a:

P(x) = Log10(x+1)-log10(x) = log10(1+1/x)

Per cui la probabilita’ che il primo numero del dato sia 1 e’ molto piu’ alta che non la probabilita’ che sia 2, e cosi’ via fino a 9.

Se non volete farvi i conti, ecco le probabilita’ per le 9 cifre:

P(1)=30,1%

P(2)=17,6%

P(3)=12,5%

P(4)=9,7%

P(5)=7,9%

P(6)=6,7%

P(7)=5,8%

P(8)=5,1%

P(9)=4,6%

Ed ecco un grafico a barre che mostra la distribuzione di probabilita’ in questione.

Non voglio fare un articolo di matematica, primo perche’ non sarei qualificato :-P, e secondo perche’ sono sicuro che annoierebbe la maggior parte di voi.

Pero’ posso dirvi, e potete approfondire nelle fonti, che si puo’ estendere la legge di Benford anche alla distribuzione di probabilita’ della seconda cifra, della terza, e cosi’ via (ovviamente la probabilita’ cambia per la seconda cifra, e per la cifra ennesima le varie probailita’ tendono ad equidistribuirsi, cioe’ a valere 11,11%).

Nel 1995 lo statistico americano Theodore Hill dimostro’ un teorema sulla legge di Benford, e porto’ avanti la teoria matematica sottostante la legge con varie pubblicazioni (di cui potete reperire i titoli sulla pagina di wikipedia dedicata a lui).

Esistono altre leggi simili alla legge di Benford, da utilizzare in altri ambiti.

Ad esempio in ambito linguistico esiste la legge di Zipf, descritta per la prima volta nel 1949 dal

linguista George Kingsley Zipf.

Benoit Mandelbroot, il padre per cosi’ dire della teoria dei frattali, dimostro’ negli anni ’50 che leggi simili possono essere dedotte a partire a dalla teoria dell’informazione di Claude Shannon.

Ma torniamo alla legge di Benford, che e’ quella che interessa a noi.

Questa legge si applica solo ad un insieme di numeri scelti a caso da una data variabile casuale, ma se vengono posti dei limiti, anche inconsapevoli, a questa variabile, l’insieme risultante potrebbe o meno obbedire alla legge..

Detta cosi’ e’ incomprensibile per molti. Cerchiamo di chiarire il punto.

Prendiamo come variabile casuale la profondita’ media di tutti i fiumi, ruscelli, fossi e rigagnoli italiani.

Otterro’ un insieme, che si suppone obbedire alla legge di benford (che, lo ripeto, e’ una legge empirica; cioe’ dedotta dalle osservazioni. In effetti la faccenda e’ piu’ complessa, ma questo non e’ un blog di matematica, quindi prendetevela cosi’ :-P; se invece non avete nulla da fare nel prossimo secolo, potete iniziare a studiarvi la funzione Z di Riemann e dimostrare la sua congettura).

Se adesso decido di prendere, come sottoinsieme, 1000 misure scelte a caso, questo sottoinsieme obbedira’ ancora alla legge di Benford.

Ma se decido di prendere, come sottoinsieme, quello delle misure comprese tra 1 e 4 metri, ovviamente questo sottoinsieme non obbedira’ piu’ alla legge di Benford (perche’ nessuna misura inziera’ con 5,6,7,8 o 9).

Ora, un insieme di Benford ha una certa varianza, una certa asimmetria, e una certa distribuzione di probabilita’.

Benford mostro’ nella sua pubblicazione che moltissimi fenomeni naturali ubbidiscono alla legge di Benford; l’area dei fiumi; la popolazione dei comuni; il numero di copie stampate dai giornali; il peso atomico; i numeri civici; i tassi di mortalita’, ecc. ecc. ecc. ecc.

Nel 1972, l’economista Hal Varian, personalita’ piuttosto importante negli Stati Uniti, suggeri’ di utilizzare la legge di Benford per verificare i dati presentati a sostegno di iniziative politiche:

se infatti e’ piuttosto facile raccogliere dei dati reali, ed e’ anche molto facile taroccarli, e’ estremamente difficile taroccare dei dati reali in maniera che continuino ad obbedire alla legge di Benford.

Talmente difficile che nel 1992 il commercialista (e matematico) americano Mark Nigrini propose di utilizzare la legge di Benford per verificare le dichiarazioni dei redditi.

E dimostro’, usando dati reali, che le dichiarazioni che non si conformano alla legge di Benford sono fraudolente.

Oggi la California e altri stati americani usano un software che verifica la corispondenza della dechiarazione alla legge di Benford, e se non c’e’ corrispondenza scatta un accertamento fiscale.

Inoltre la legge di Benford puo’ essere estesa anche alle altre cifre, come gia’ detto.

Puo’ essere estesa alle prime x cifre, o alle ultime x cifre, e cosi’ via.

E presenta la notevole proprieta’ di essere invariante di scala: se cioe’ un insieme e’ un insieme di benford (esempio, la lunghezza media di tutti i corsi d’acqua espressa in metri), lo sara’ anche l’insieme ottenuto da quello moltiplicandolo per una qualsiasi costante x (esempio, la stessa lunghezza di prima ma ora espressa in piedi).

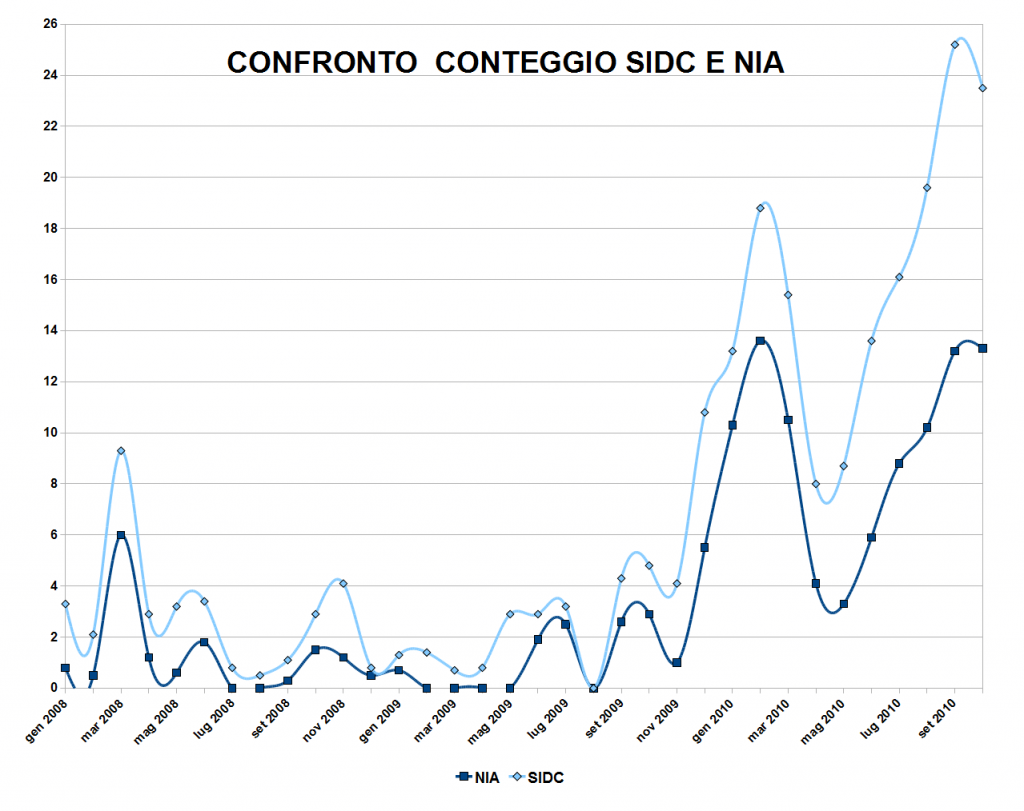

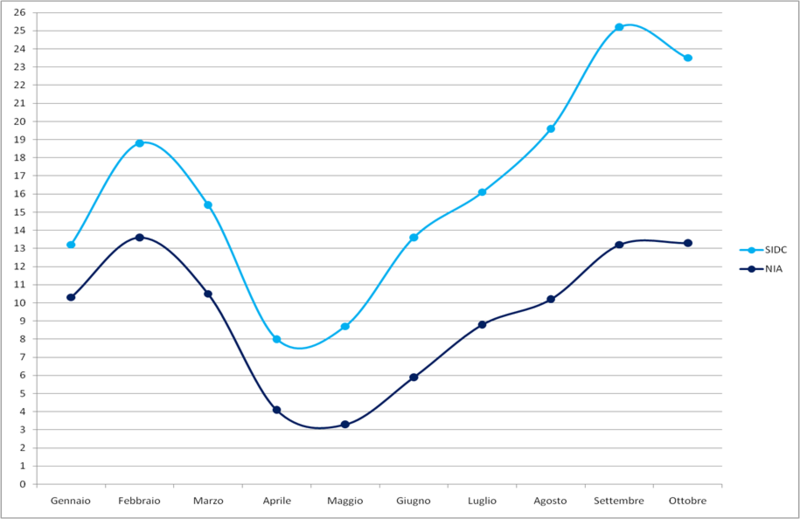

Bene, torniamo a noi, e ai dati del sole.

Sono andato al link gentirmente fornitomi da Andrea B (http://www.ngdc.noaa.gov/nndc/struts/results?t=102827&s=5&d=8,430,9 ) e mi sono scaricato i dati mensili del sidc a partire dal 1749.

I dati arrivano fino al 2011, sono abbastanza.

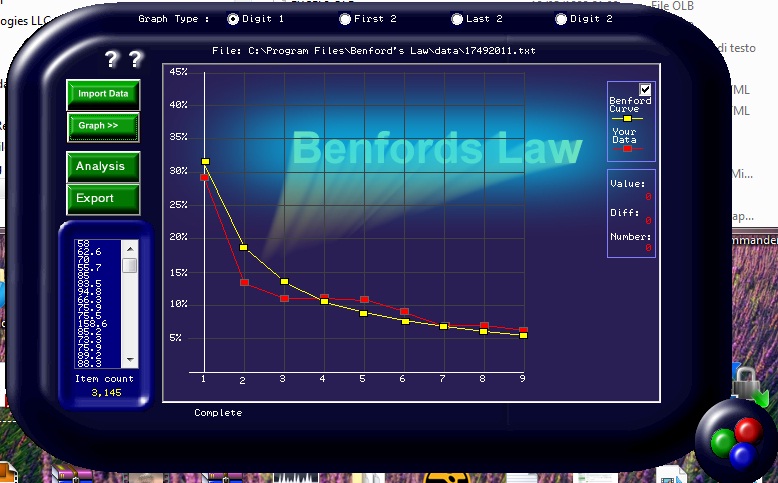

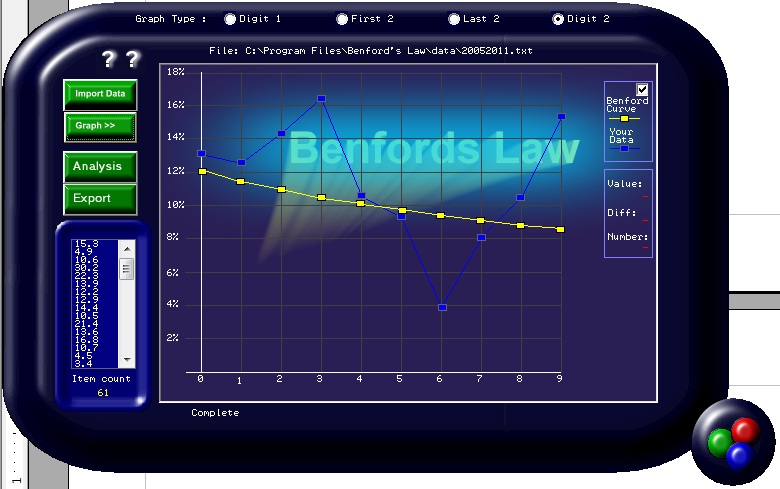

Nella figura, vediamo la distribuzione di benford teorica e quella reale, per tutti i dati a partire dal 1749:

Come potete vedere i dati seguono abbastanza l’andamento della legge di benford, almeno a occhio (francamente non mi va di riprendere in mano il manuale di statistica e mettermi a fare un’analisi piu’ approfondita; per i nostri scopi qui ed ora, l’occhio e’ piu’ che sufficiente :-P)

I valori oscillano tra 0 e 253,8, con un valore medio di 51,89.

Questo spiega perche’ le frequenze del 4 del 5 e del 6 siano leggermente superiori alla media.

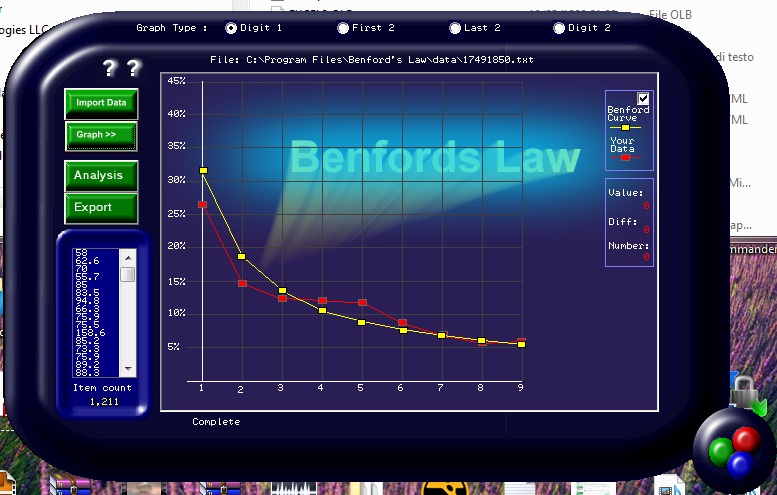

Ora, ho diviso i dati in 3 sottoinsiemi: 1749-1849, 1850-1949, 1949-2005, e poi ho fatto un altro sottoinsieme, dal 2006 al 2011.

Ecco cosa accade tra il 1749 e il 1849:

Abbastanza simile all’immagine precedente.

Ora l’intervallo 1850-1949:

Questa immagine comincia ad essere un po’ diversa… Anche il 7, l’8 e il 9 hanno una frequenza maggiore.

Ad ogni modo, il pattern di Benford (la linea gialla) e ancora rispettato, piu’ o meno.

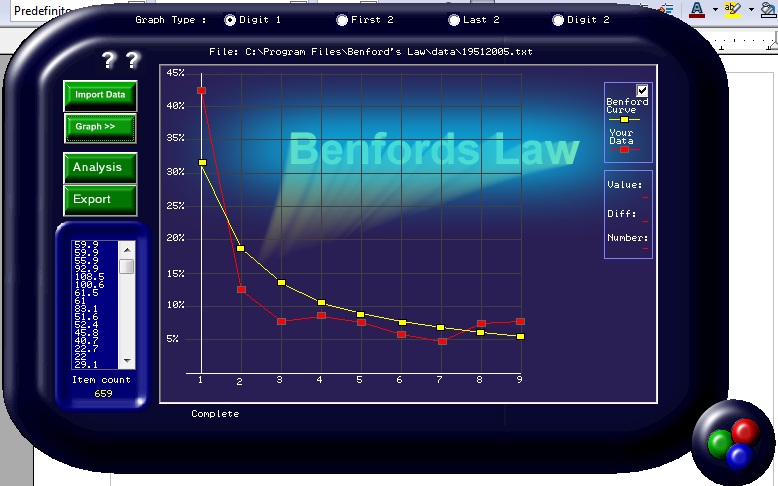

Ma vediamo cosa accade con i dati dal 1950 al 2005:

Abbiamo ancora, piu’ o meno, una curva di Benford, solo che l’1 va chiaramente fuori (piu’ del 10% di

differenza; tutti gli altri numeri, a parte l’8 e il 9, mostrano valori minori di quelli attesi, ma di poco.

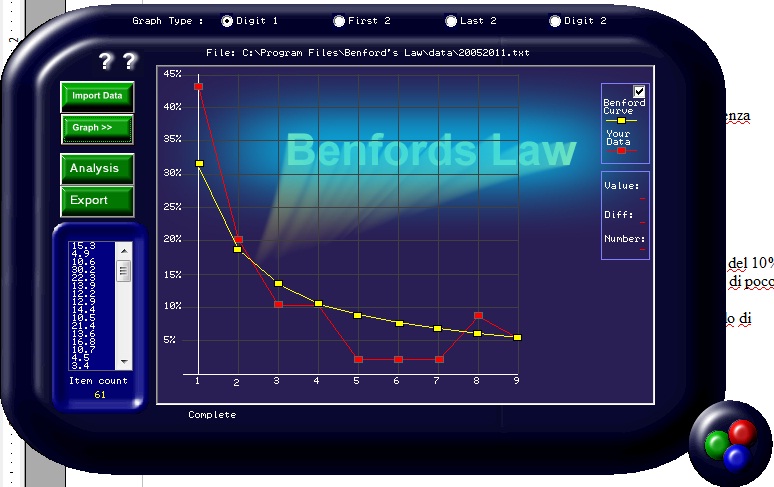

E vediamo adesso I dati dal 2006 al 2011, quelli piu’ influenzati dai cambiamenti nel metodo di conteggio:

Dei vari grafici, questo e’ quello piu’ anomalo.

Chissa’ perche’?

Ma non e’ finita.

Abbiamo analizzato la distribuzione della prima cifra, vediamo ora la distribuzione della seconda cifra:

1749-1849

1849-1949

1949-2005

2006-2011

AAAAARGHHHHH!!!!!!!!!!!!!!

Cosa e’ successo???

E’ andato tutto in vacca!!!

L’andamento della seconda cifra, nei dati mensili del SIDC dal 2006 al 2011, non ha piu’ nulla a che fare con la legge di Benford.

Ora, una volta in rete si trovavano dei software (tipo quello che ho usato io per questi grafici) per calcolare vari parametri di una distribuzione e verificare che si conformasse alla legge di Benford.

Adesso, non esistono piu’: sono riuscito a trovarne solo uno, ma non funziona.

E il sw che ho utilizzato io (che essendo fortunatamente previdente avevo salvato in un vecchio backup) ora non e’ piu’ disponibile in rete.

Inoltre era stato fatto credo per il 486 e per una versione precedente di windows, infatti per reinstallarlo mi sono dovuto sbattere non poco, e alcune funzionalita’ non vanno piu’ (presumo siano cambiate alcune librerie con winzoz 7).

Spero comunque di avervi fatto conoscere qualcosa di nuovo, e di avervi indicato una strada.

Il punto e’: ma la legge di Benford e’ una vera legge fisica, che si applica a qualunque misura di un fenomeno naturale, o no?

Credo che al momento non si possa rispondere a questa domanda, ma I miei strumenti matematici sono piuttosto limitati, e soprattutto molto ma molto arruginiti. Magari qualcuno all’ascolto puo’ aiutarci.

Una cosa mi sento di poter affermare senza timore di essere smentito:

la legge di Benford e’ abbastanza valida da poter essere usata per stabilire se frodiamo il fisco, almeno negli USA.

Ma sono sicuro che se la usassimo per dimostrare che il fisco froda noi, cioe’ se la usassimo per dimostrare che I dati dell’AGW sono taroccati, allora qualche solerte istituzione statale prontamente dimostrerebbe che a tali dati non si puo’ applicare la legge di Benford.

Io personalmente ritengo che si applichi a qualunque misura di un fenomeno naturale, ma conto poco.

Di sicuro vi consiglio di applicarla ai prospetti informativi che vi fanno firmare prima di vendervi azioni, assicurazioni, e quant’altro ;-).

Pierluigi

Fonti:

http://it.wikipedia.org/wiki/Hal_Varian

http://www.cut-the-knot.org/do_you_know/zipfLaw.shtml

http://it.wikipedia.org/wiki/Ted_Hill

http://it.wikipedia.org/wiki/Legge_di_Benford

http://it.wikipedia.org/wiki/Legge_di_Zipf

http://it.wikipedia.org/wiki/Hal_Varian