Articolo sexy ?

Certo che no, per “seno” intendo, ovviamente, la funzione trigonometrica. Volevo piuttosto parlare molto terra-terra di come una “messe” di dati sperimentali possa venire interpretata e trattata.

E di come quei dati, oggettivamente obiettivi, possano prestarsi a dar ragione alle più diverse ipotesi.

Studiando e misurando un fenomeno possiamo, a grandi linee, pensare che ci siano due casi :

– Ho ipotizzato in qualche modo una regola che governa il fenomeno e voglio verificare se i dati la confermano

– Non ho idee teoriche ma voglio cercare di “prevedere” ed analizzare il comportamento del sistema

Cominciamo ?

Prendiamo un caso semplice semplice… La legge puo’ essere schematizzata con una bella retta.

Quindi prendo i miei dati , li piazzo su un grafico cartesiano e vedo se ci passa una retta …..

Troppo facile ?

Direi di si, e per vari motivi. Intando, essendo dati sperimentali, ben difficilmente saranno perfettamente allineati e quindi avremo una miriade di retta, una per ciascuna coppia di punti presenti sul grafico….

Allora come facciamo ? Be, possiamo utulizzare ( e si utilizzano, nella realtà) parecchi metodi … da quello grafico della “retta di massima e minima pendenza” , dove si cerca, proprio con la riga, di tracciare le due rette a massima pendenz a e a minima pendenza che “becchino” almeno due punti, facendo poi la media dei coefficenti angolari e degli “offset” (termine costante) , come mostro nella figura a fianco, fino a metodi via via più raffinati dove si cerca, con calcolo numerico, la retta che va a minimizzare le distanze dai vari punti (conosciuto com emetodo dei “minimi quadrati” , perchè in effetti e’ più efficente minimizzare il quadrato della distanza…) .

a e a minima pendenza che “becchino” almeno due punti, facendo poi la media dei coefficenti angolari e degli “offset” (termine costante) , come mostro nella figura a fianco, fino a metodi via via più raffinati dove si cerca, con calcolo numerico, la retta che va a minimizzare le distanze dai vari punti (conosciuto com emetodo dei “minimi quadrati” , perchè in effetti e’ più efficente minimizzare il quadrato della distanza…) .

Fin qui niente di strano. Ma i dati sperimentali hanno anche delle altre particolarità.

Hanno l’errore.

Occorre dunque immaginare che, attorno ad ogni punto sia presente “un’area di incertezza” , dovuta agli errori di misura, a quelli di elaborazione dei dati, al fatto che i dati sono una media e quindi ne rappresento la dispersione, al fatto che i dati sono stati misurati in epoche diverse, con diversi metodi etc. L’area potrebbe avere le forme piu’ strane ma in generale si tende ad evidenziare l’errore sull’asse verticale (le Y)…Cioe’, furbescamente, si mette come asse verticale (o si elaborano i dati in modo che sia) quello dove si ha l’errore piu’ evidente.

I metodi per ritrovere la nostra retta sono abbastanza simili ai precedenti… solo che si dovrà tener conto del fatto che i punti che hannop un errore “piccolo” dovranno essere i più vicini alla curva (Eh si… anche le rette sono “curve”) . Come vedete dal grafico, pur essendo i dati esattamente gli stessi delle immagini precedenti, l’interpretazione e’ molto diversa. I tre punti con il piccolo errore condizionano le rette di massima e minima pendenza facendole allontanare dalla maggior parte degli altri “punti” (tra virgolette perche’ intesi come “punto senza errore”) . Eppure le rette più “attendibili” sono quelle.

Da questo deriviamo un primo insegnamento…

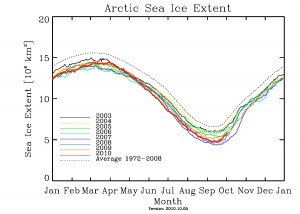

Un grafico senza barre di errore… e’ quantomeno sospetto…

Poi esistono dei metodi di analisi dati che permettono di valutare la bontà di una ipotesi : io ricordo il cosiddetto metodo del chi quadro (chi sarebbe la lettera greca, non il pronome….) ma penso che ne esistano altri…. Alla fine del “test” si ha un responso sull’ipotesi : “non rappresenta i dati” , “puo’ rappresentare i dati più o meno bene ” , rappresenta i dati in modo” sopspettosamente buono”…

SOSPETTOSAMENTE BUONO : qui entriamo nella seconda parte dell’articolo….

Infatti se ho una quantità finita di dati (e per essere unamanamente comprensibili i dati saranno sempre “finiti”) posso inventare una quantità di metodi per “fittarli”. Ad esempio e’ possibile usare dei polinomi : Un polinomio (ricordo dalle scuole medie) e’ una funzione rappresentata da una serie di potenze crescenti …. a+bx+ cx^2+dx^3 ….. ecc. Dato un numero N di dati un polinomio di ordine N-1 li “fitta” perfettamente . E fin qui non c’e’ nulla di strano.

Se andiamo un po’ piu’ avanti nella teoria matematica possiamo introdurre le cosiddette “serie di Taylor” : E’ sempre possibile approssiamre una qualunque funzione nei “dintorni” di un determianto punto con una opportuna serie di polinomi. L’errore che si commette nell’approssimazione e’ riducibile a piacere “allungando” la serie di polinomi (Al limite l’errore si annulla se la serie diventa infinita) …. Nella figura : una sinusoide approssimata nello zero con polinomi di ordine crescente (Da Wikipedia) )

E qui vi metto una pulce nell’orecchio. Se consideriamo le due affermazioni, possiamo vedere che con un minimo di malafede e’ possibile “far sembrare vera” una ipotesi qualsiasi (be, quasi…) “calibrando” bene il numero di polinomi con cui si sviluppa la serie….E’ chiaro che solo gli addetti ai lavori potranno avere sospetti …. E solo con test approfonditi potranno “smentire” le conclusioni…. E lo so perchè …. Mi e’ capitato di doverlo fare… Per ordini “superiori”… (Che vergogna)

Per concludere, Visto che ho citato le serie di Taylor, volevo accennarvi anche alle “serie di Fourier” . Chi pasticcia con le misure di segnali periodici le conosce bene . Un segnale periodico e’ approssimabile con una opportuna somma di componenti “sinusoidali” di frequenza multipla (chiamate “armoniche”) . Il metodo e’ potentissimo. Tramite un opportuno algoritmo e’ possibile “estrarre” dai dati le “frequanze fondamentali” e le varie armoniche che lo compongono. Pero’… Anche in questo caso si possono prendere “abbagli” legati al cosiddettto “aliasing” e che un malfidato come me vede sempre come possibili metodi per …. … … Diciamo … … … Imbrogliare….

Ma forse ne parlerò in un altro articolo

Luca Nitopi

nei dispositivi .

nei dispositivi .