Il 1 ° luglio 2015, il Data Center Mondiale SILSO porrà una pietra miliare senza precedenti nella lunga storia del conteggio delle macchie solari.

Con la sua longevità, questo riferimento, il conteggio delle macchie solari, rimane il nostro unico riferimento diretto per ripercorrere l’attività solare negli ultimi 4 secoli, ed è sicuramente il più utilizzato set di dati solari (più di 100 pubblicazioni all’anno). Tuttavia, questa serie è stata lasciata invariata dalla sua creazione da Rudolph Wolf, nel 1849, senza alcuna verifica a ritroso. L’unica innovazione si è verificata nel 1998 con la creazione di un nuovo indice delle macchie solari simile, il numero per gruppo (Hoyt e Schatten 1998). Tuttavia, le due paralleli serie mostravano forti differenze, accennando ad una forte disomogeneità o in serie o in entrambi. Dal 2011, un gruppo di 40 esperti, infine, ha effettuato una revisione completa di questi due serie al fine di individuare e correggere i difetti. Questo enorme lavoro è stato co-organizzato da E. Cliver (NSO, Sacramento Peak Observatory), F. clette (WDC-SILSO, STCE) e L. Svalgaard (Stanford University) su quattro workshop successivi (una delle quali presso l’Osservatorio Reale a Bruxelles nel 2012. Vedi immagine sotto)

Ora, finalmente, tutte le correzioni sono state finalizzate (per una recente sintesi, vedere Clette et al. 2014, Space Science Reviews). Nel corso degli ultimi mesi, tutte le correzioni ottenute separatamente, spesso da diversi scienziati, sono stati infine assemblate in una ricostruzione finale, nel numero di macchie solari e nel gruppo di macchie solari.

La figura seguente, illustra la variazione tra la serie originale e il nuovo sunspot number. La correzione più notevole è un abbassamento di circa il 18% di tutti i numeri dopo il 1947, per rimuovere il pregiudizio prodotto da un nuovo metodo di conteggio, iniziato nel 1947, a Zurigo. Una grande deriva delle variabili che interessano il conteggio di “Bruxelles-Locarno”, dal 1981, è stato eliminato.

Si noti, che per il nuovo numero SSN, il fattore tradizionale 0,6 di Zurigo non è più utilizzato, il che aumenta in modo significativo la portata di tutta la serie. Questo riflette semplicemente la scelta dei conteggi moderni di A. Wolfer, il successore di Wolf, come nuovo riferimento. I nuovi numeri così corrispondono ora molto più da vicino i numeri grezzi di Rudolph Wolf, ottenuti da tutti gli osservatori, dal 1993 fino ad oggi.

Indipendentemente, il numero del gruppo è stato corretto per una grande sottostima di tutti i valori prima del 20° secolo (vedi figura sotto), a causa dell’instabilità dei dati di riferimento utilizzati da Hoyt e Schatten: vale a dire i dati fotografici dell’Osservatorio Reale di Greenwich. Come potrebbe essere costruito, un database completo di tutti i conteggi dei gruppi del passato, il nuovo numero di gruppo, in realtà, consiste in una serie completamente ricostruita, piuttosto che una correzione applicata ai numeri originali.

Ora, finalmente, siamo in grado di portare le due serie insieme e osservare l’impatto delle correzioni sui disaccordi originali. Le due figure seguenti, mostrano come le grandi divergenze che caratterizzavano il numero della prima serie del SSN e del gruppo, sono ora stati fortemente ridotti. Bisogna precisare che tale miglioramento non è stato ottenuto da una scala reciproca ad-hoc tra le serie. Al contrario, come le correzioni sono state determinate separatamente, in base ai diversi set di dati e tecniche, l’accordo finale porta un ulteriore conferma della validità di tali correzioni.

Ancora, come si può vedere, le deviazioni permangono notevoli, soprattutto prima 1825, quando le osservazioni diventano scarse e in periodi di attività minima (basso). Quindi, ancora molto lavoro resta sicuramente da fare per molti anni a venire, ma dati gli importanti miglioramenti raccolti in questa fase, il WDC – SILSO, sta per procedere al rilascio pubblico di questa nuova versione.

La preparazione di questa importante operazione è ormai quasi completata, ed ha richiesto un enorme lavoro organizzativo e di programmazione del piccolo team SILSO. Infatti, il rilascio della nuova serie del SSN è solo un punto di partenza per la WDC-SILSO. Anzi, richiede una profonda rielaborazione del software operativo, che elaborerà i dati attraverso la nostra rete in tutto il mondo, il 1 ° luglio e in futuro. In effetti, i vari prodotti devono essere resi perfettamente compatibili con la serie totale del SSN: il numero di macchie solari emisferico, il quotidiano stimato Sunspot Number, le previsioni solare del ciclo di 12 mesi, tutti i grafici di dati e la derivazione dei coefficienti k personali per tutte le stazioni della rete.

Inoltre, vogliamo integrare anche una gestione strutturata del numero delle macchie solari (sotto la supervisione della International Astronomical Union), ri-progettando la sezione dati del nostro sito Web SILSO. In parallelo, stiamo anche lavorando sulla questione tematica, sulla rivista Solar Physics, che sarà interamente dedicata alla nuova taratura del numero SSN (aperto alle carte fino alla fine di ottobre 2015, in vista di una pubblicazione nei primi mesi del 2016). Rivista, nella quale, sarà pienamente documentata la presente modifica.

Le ultime settimane e negli ultimi giorni sono stati quindi particolarmente frenetici per il team SILSO. Faremo del nostro meglio, per ottenere questo importante transizione il 1 ° luglio, con minori disturbi, per i nostri utenti. Tuttavia, dato il numero di modifiche simultanee, il trattamento sarà probabilmente più lento del solito per consentire verifiche accurate. Chiediamo perciò ai nostri numerosi utenti di essere maggiormente pazienti, in questa occasione. Poiché i problemi non possono mai essere esclusi. Siamo quindi pronti ad accogliere qualsiasi commento, su problemi rilevati.

Dopo una vita piuttosto tranquillo, nel corso degli ultimi 166 anni, il numero delle macchie solari sta quindi per rinascere, in una nuova versione, da mercoledì 1° luglio. Ci auguriamo che la comunità scientifica accoglierà questo nuovo insieme di dati e apprezzerà il notevole sforzo, realizzato nel corso degli ultimi quattro anni, per produrre un punto di riferimento migliore per lo studio della relazioni solari-terrestri, nel lungo termine.

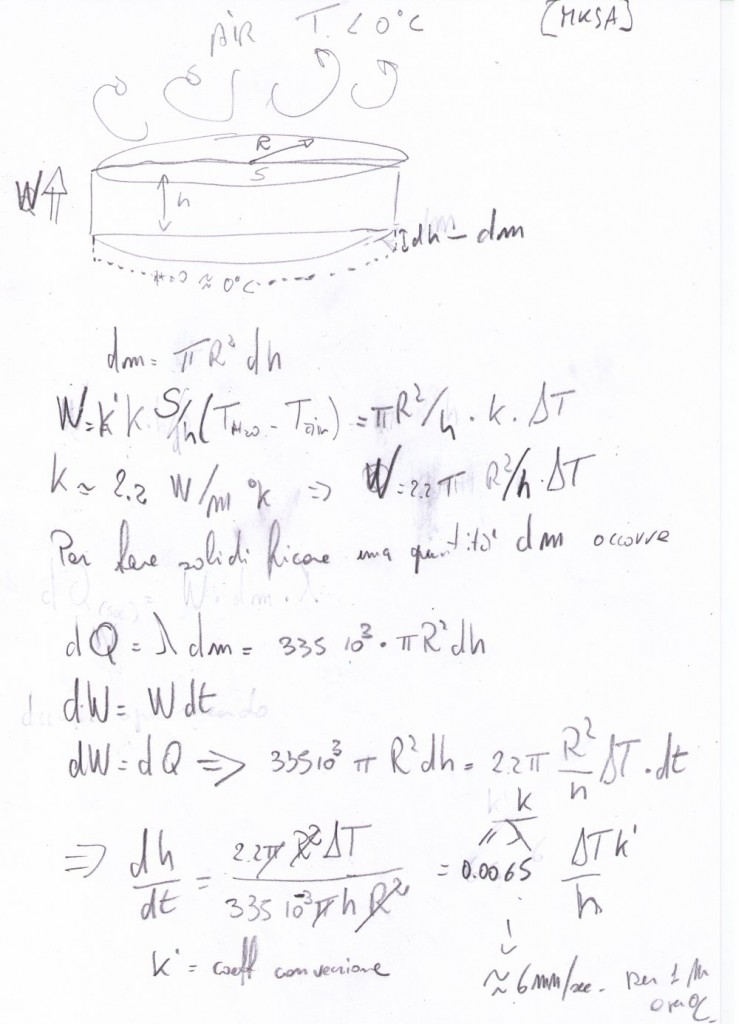

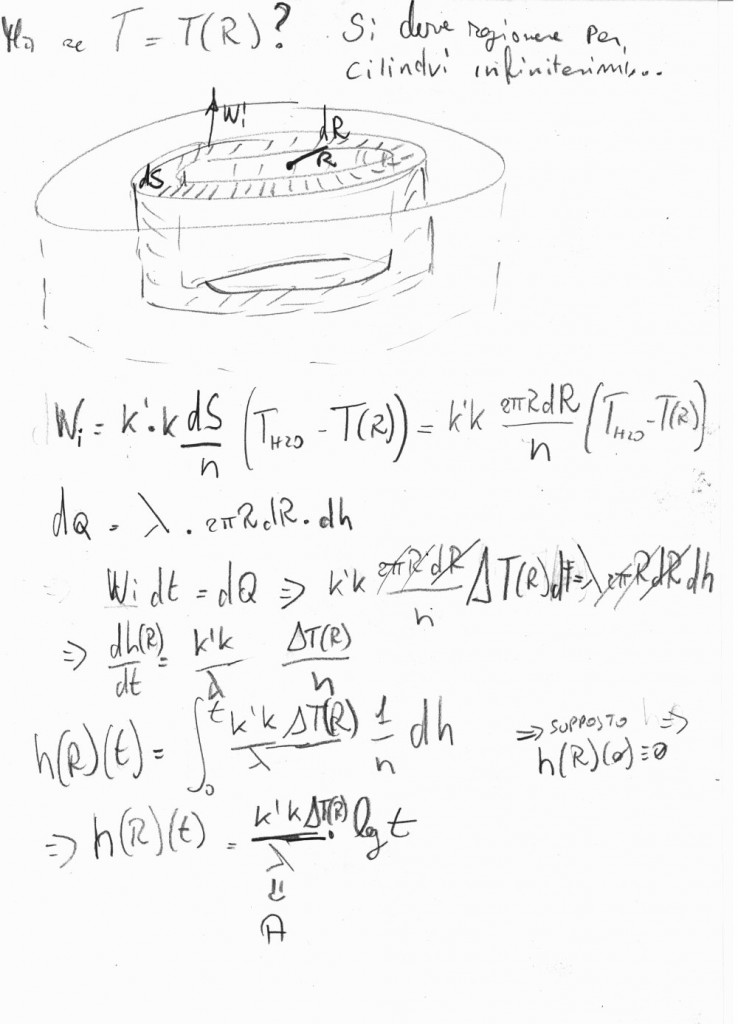

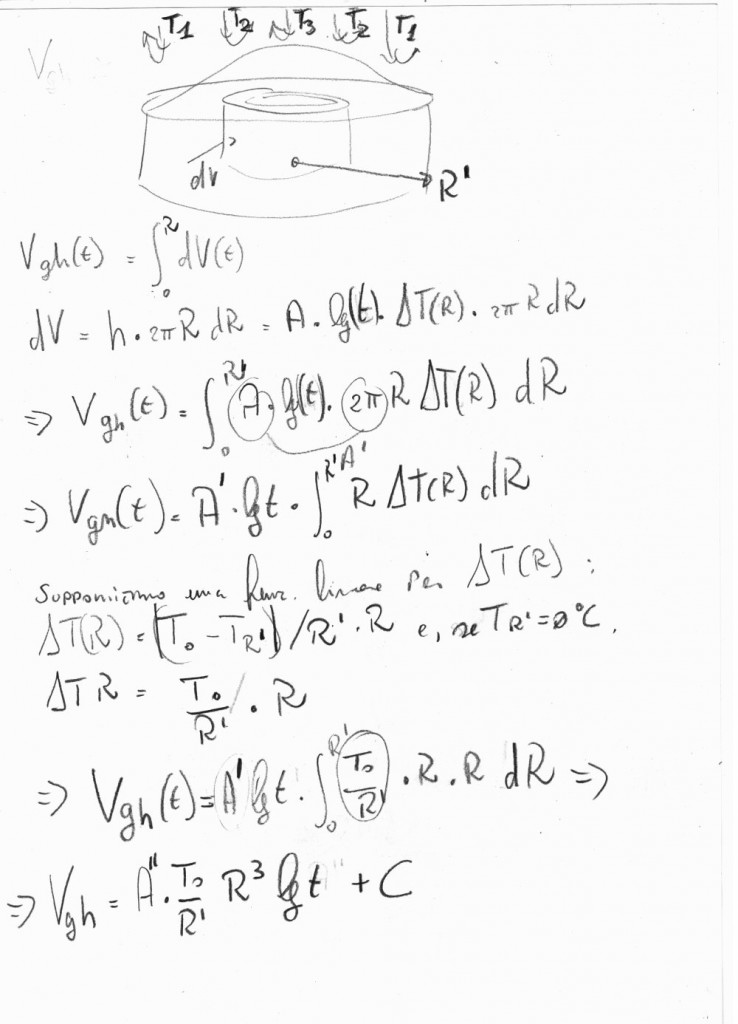

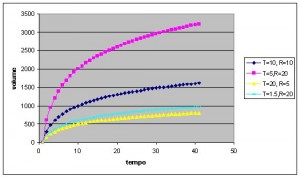

nel tempo con legge LOGARITMICA (quindi pian piano la formazione rallenta, senza per altro fermarsi mai… vedi grafico del logaritmo preso da wikipedia , la parte che ci interessa e’, ovviamente, quella positiva del grafico in quanto ghiaccio con spessore negativo non ha molto senso fisico… )

nel tempo con legge LOGARITMICA (quindi pian piano la formazione rallenta, senza per altro fermarsi mai… vedi grafico del logaritmo preso da wikipedia , la parte che ci interessa e’, ovviamente, quella positiva del grafico in quanto ghiaccio con spessore negativo non ha molto senso fisico… )

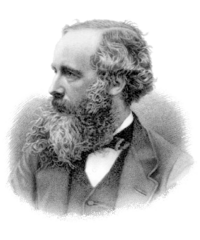

E’ J.C. Maxwell, noto sicuramente per essere stato il primo a scrivere (e, diceva un mio prof., l’unico a risolvere in cooordinate cartesiane…) le relazioni che legano il campo magnetico al campo elettrico, che prevedono l’esistenza delle onde elettromagnetriche e che affermano che la velocità di tali onde e’ costante (da cui la crisi di un pezzo della fisica classica… ma ne parlerò in un altro articolo) . Ma il Nostro era (come gran parte degli studiosi dell’epoca) molto eclettico e le sue ricerche ed interessi spaziavano anche nel campo della termodinamica.

E’ J.C. Maxwell, noto sicuramente per essere stato il primo a scrivere (e, diceva un mio prof., l’unico a risolvere in cooordinate cartesiane…) le relazioni che legano il campo magnetico al campo elettrico, che prevedono l’esistenza delle onde elettromagnetriche e che affermano che la velocità di tali onde e’ costante (da cui la crisi di un pezzo della fisica classica… ma ne parlerò in un altro articolo) . Ma il Nostro era (come gran parte degli studiosi dell’epoca) molto eclettico e le sue ricerche ed interessi spaziavano anche nel campo della termodinamica. Una scatola, tante sferette che rimbalzano contro le pareti… ma che sono talmente piccole da rendere trascurabile gli urti tra di loro.

Una scatola, tante sferette che rimbalzano contro le pareti… ma che sono talmente piccole da rendere trascurabile gli urti tra di loro.

a e a minima pendenza che “becchino” almeno due punti, facendo poi la media dei coefficenti angolari e degli “offset” (termine costante) , come mostro nella figura a fianco, fino a metodi via via più raffinati dove si cerca, con calcolo numerico, la retta che va a minimizzare le distanze dai vari punti (conosciuto com emetodo dei “minimi quadrati” , perchè in effetti e’ più efficente minimizzare il quadrato della distanza…) .

a e a minima pendenza che “becchino” almeno due punti, facendo poi la media dei coefficenti angolari e degli “offset” (termine costante) , come mostro nella figura a fianco, fino a metodi via via più raffinati dove si cerca, con calcolo numerico, la retta che va a minimizzare le distanze dai vari punti (conosciuto com emetodo dei “minimi quadrati” , perchè in effetti e’ più efficente minimizzare il quadrato della distanza…) .