È un lungo post (forse troppo) ma la costruzione del mito del buco dell´ozono serve da esempio di come é nato un altro mito, quello del riscaldamento globale. A proposito lo dico da sempre che é esistito un riscaldamento globale negli anni 90 ma che in maggior parte questo é dipeso dalla fortissima attivitá solare nei cicli 20-21-22 e 23, e in minima parte dall´attivitá umana.

Negli anni ’70 la paura della desertificazione era ampiamente diffusa, quasi fosse una predicazione quasi religiosa. In seguito a questo test preliminare, l’ozono e la sua variabilità sono apparsi come un primo problema da risolvere in tutto il mondo, come se fosse causato direttamente dall’uomo. Questo fu a seguito da un ordine del giorno creato nel Club di Roma nel 1962, dove fu tracciato il futuro dell’umanità.

I MITI DELL’OZONO:

Proprio come non c’è vita come la conosciamo senza anidride carbonica (CO2), non c’è ozono naturale (O3) senza luce solare. Queste sono affermazioni che non possono essere confutate. In questo modo, è necessario comprendere il processo di formazione dell’ozono, la sua variazione e la storia che ha registrato il considerato “errore scientifico del XX secolo”, in cui un fenomeno naturale è stato trasformato in un’emergenza globale.

L’ozono è conosciuto giá dall’antica Grecia, e non era intesao come gas, ma già si associava la sua presenza al maltempo. Il prefisso “ozo” deriva dal significato di “con aroma o odore forte e caratteristico” ; alcune definizioni lo descrivono come penetrante e spiacevole. La letteratura riferiva al chimico tedesco Christian Friedrich Schönbein la scoperta di questa molecola, proprio come la percepivano i Greci: l’odore acre, forte, ossidante che appare durante i temporali, che, attraverso i loro fulmini causava l’elettrosintesi delle molecole, usando ossigeno molecolare (O2) presente nell’aria (TOMASONI, 2011). In questo modo, richiede energia per la sua formazione, e poiché è una sostanza altamente reattiva, è una delle componenti variabili dell’atmosfera terrestre, che viene continuamente riciclata nei processi naturali, di cui il principale, la radiazione sarà discusso in questo articolo.

. I primi strati dell’atmosfera e la formazione dell’ozono

Comprendere la formazione dell’ozono richiede l’interpretazione di alcuni punti fondamentali e importanti nella fisica e della chimica dell’atmosfera. La formazione di gas atmosferici è praticamente stabile fino all’altitudine di 80 km. I principali gas sono l’azoto, con il 78,0% e l’ossigeno, con il 21,0%. L’argon è la terza e la più bassa, con solo lo 0,93%. Tutti gli altri sono chiamati trattini, contenuti in 0,07%. Il gas dissigeno, con due atomi nella sua formazione, è chiamato ossigeno molecolare. Agisce come materia prima per la formazione del gas dell’ozono, che diventerà uno stato transitorio di ossigeno, quando capita di avere tre atomi nella sua formazione. La durata dell’ozono nell’atmosfera è molto breve perché la sua molecola è altamente reattiva. L’ozono ha bisogno di energia che possa causare instabilità nell’ossigeno molecolare stabile. L’unica fonte di energia è quella del sole, la frequenza delle onde corte, in particolare la radiazione ultravioletta. Poiché l’atmosfera terrestre agisce in modo selettivo sulle energie esterne al sistema, le frequenze ultraviolette sono le prime a essere bloccate, cominciando a verificarsi in alta quota. Questa interazione richiede massa, cioè molecole.

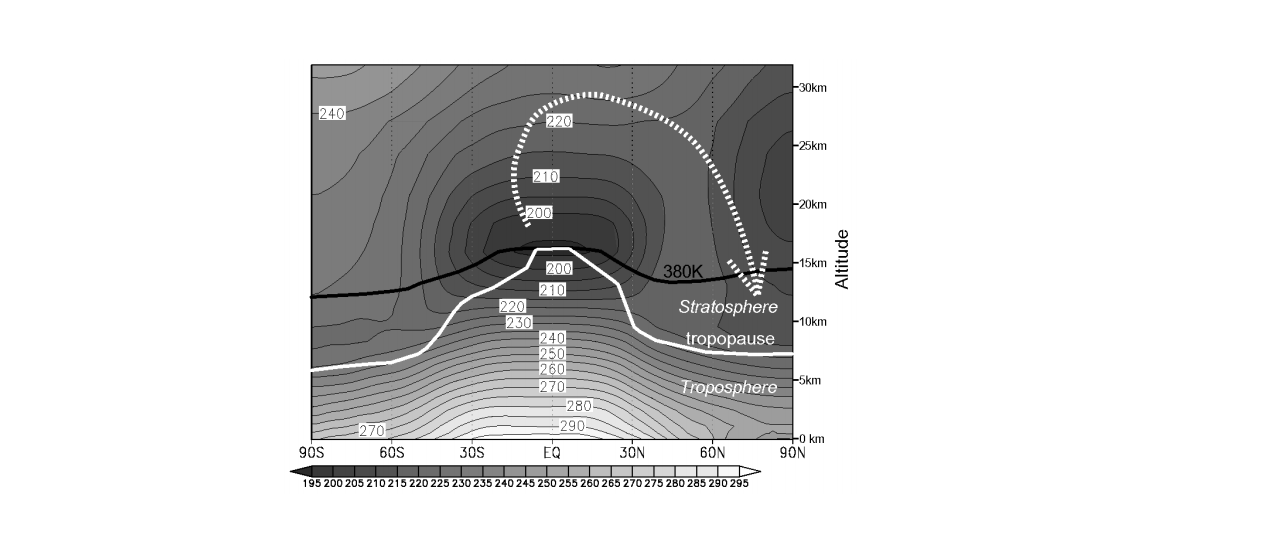

La troposfera, il primo strato dell’atmosfera, vicino alla superficie della Terra, detiene circa il 90% dell’intera massa. Inoltre c’è uno strato intermedio chiamato tropopausa e sopra questo, la stratosfera, dove la pressione atmosferica può variare da 50mb nella parte inferiore, a 10mb nella parte più alta, essendo estremamente tenue, poiché la pressione del mare medio – PNMM è 1013.25mb. Tuttavia, anche con una densità sottile, la massa atmosferica è sufficiente in modo che le interazioni con le brevi lunghezze d’onda elettromagnetiche della radiazione ultravioletta dal Sole possano verificarsi in tutta la stratosfera. Poiché la densità è più alta nella stratosfera inferiore, avremo la più alta concentrazione di gas ozono. Per quanto riguarda le temperature, i valori più alti, intesi come energia cinetica, sono registrati nella parte più alta, perché queste molecole intercettano i raggi elettromagnetici di maggiore energia. In questo modo, la stratosfera presenta un profilo molto stabile, poiché è caldo nella parte superiore, presentando generalmente zero gradi Celsius e freddo nel fondo, con circa -56,0 ° C, valori medi verificati in un’atmosfera considerata standard dall’Organizzazione Meteorologica mondo.

Durante il processo di intercettazione delle radiazioni avviene la fotolisi o la fotodisessione, in cui le molecole si rompono formando alcuni radicali liberi o atomi. Nel processo, l’energia ultravioletta viene assorbita per rompere la stabilità molecolare, con conseguente emissione di radiazioni a onda lunga nella banda a infrarossi, che a sua volta riscalda notevolmente lo strato. In questo modo, dovrebbe essere compreso che tutte le molecole che raggiungono la stratosfera o qualsiasi strato superiore saranno fotodiallocate da radiazioni ad alta energia incidente. Quindi, i due principali gas, l’azoto e quindi l’ossigeno, sono molto più soggetti a questi processi. Poiché la quantità di ossigeno e radiazioni UV è molto grande, la formazione di ozono è stimata in circa diversi milioni di tonnellate al secondo, poiché solo allora potrebbe contribuire significativamente a riscaldare e stabilizzare la stratosfera.

Pertanto, l’ozono è un gas che si forma quando il secondo gas principale nell’atmosfera, il gas dell’ossigeno interagisce con la radiazione ultravioletta della banda C-UV C, altamente dannoso per gli esseri viventi. In questi termini, questa radiazione fatale non raggiunge la superficie a causa dell’ossigeno molecolare. Da questa interazione nasce l’ossigeno atomico (O “), altamente instabile, ma necessario per essere il precursore della formazione di ozono. Quindi, nella sua breve esistenza, l’ozono interagisce anche con le radiazioni ultraviolette, ma a causa delle sue proprietà chimiche, la frequenza dell’interazione si verifica nella banda B – UV B, ad un’altitudine di almeno 10 km superiore all’altitudine della sua formazione. In questo modo, il controllo dell’incidenza delle radiazioni ultraviolette B sulla superficie terrestre viene misurato dalla concentrazione di ozono nella stratosfera, che è altamente volatile, poiché le probabilità che una molecola ne trovi un’altra sono molto alte e quando questo si verifica, tre di nuovo le molecole di ossigeno, ritornando alla stabilità e rilasciando più calore nella stratosfera. Il processo di scambio tra questi gas è espressivo veloce. Poiché la concentrazione di gas è più elevata alla base della stratosfera, anche la concentrazione di ozono (O3) sarà così, e questa parte della base della stratosfera è conosciuta come ozonosfera perché contiene la maggior parte della concentrazione di nubi di ozono che si formano e scompaiono con incredibile velocità. Pertanto, non esiste un tale “strato di ozono”, ma è più probabile che questo settore osservi la sua formazione. Va notato che la radiazione UV-A non ha la stessa interazione con le molecole di O 2 come la radiazione UV C o UV B, partecipando così di più al processo di diffusione, che non è sufficiente a bloccare gran parte del suo flusso , che finisce sulla superficie terrestre (figura 4.1.1).

|

Fig.4.1.1 : Bande spettrali di radiazione ultravioletta e loro estinzione mentre attraversano gli strati inferiori dell’atmosfera. La più grande produzione di ozono si verifica alla base della stratosfera (Fonte: adattamento di Felicio, 2009). |

La produzione eseguita dai processi fotochimici è solitamente insignificante sotto i 20 km di altitudine:

In effetti, la quantità di ozono che esiste è così insignificante che Gordon Miller Bourne Dobson (1889-1976), un fisico britannico e meteorologo, uno dei principali ricercatori sull’argomento, ha creato una procedura per la sua valutazione. Se l’intera colonna di aria atmosferica fosse concentrata e ridotta ad una pressione atmosferica nota, il NMM, quindi 1atm o 1013.25mb, e ad una temperatura fissa nota, nel caso Celsius zero gradi, lo spessore della quantità totale di ozono sarebbe solo 3 mm. Dobson attribuiva ogni millimetro a 100 unità Dobson e trovava che la media di questa concentrazione sarebbe 300UD. Qui è importante sottolineare che, proprio come la scienza crea medie per essere in grado di fare riferimento, come l’esempio PNMM stesso, dove i valori superiori a 1013.25mb sono considerati come alta pressione superficiale o anticicloni, e al di sotto di questa, bassa pressione atmosferica in superficie, o cicloni, qualsiasi valore superiore a 300UD sono solo “anomalie” positive e valori al di sotto, anomalie “negative”. Tali anomalie non dovrebbero mai essere intese come un problema, ma come una variante di un sistema o di un processo che non è fisso e che si verifica migliaia di anni fa, se non di più. Questo è talmente ovvio per la Scienza che è sorprendente che non abbiamo ancora commentato la variabilità del parametro stesso, sebbene ci siano diversi articoli che riportano che tale variabilità è naturale, come dimostrerebbe lo stesso Dobson.

.

La variabilità dell’ozono è sempre stata naturale

Variazioni nella concentrazione di ozono sono sempre esistite e sono state segnalate giá dal 1930. Nel 1950, R. Penndorf del laboratorio United States Air Force (USAF) di Cambridge, USA, analizzò i dati del TronsØ , Norvegia settentrionale, da una serie dal 1926 al 1942. Durante questa valutazione, ha trovato valori inferiori a 50UD, seguiti nell’ora successiva da valori superiori a 500UD. Ha concluso che la variazione ha raggiunto il 1000% da un’ora all’altra, la dimensione era l’effetto reattivo di questa molecola come uno stato transitorio di ossigeno. Erano queste anomalie che chiamava “buchi nello strato di ozono” come espressione figurativa che non è mai stata presa in considerazione fino alla fine degli anni ’80.

Con la pianificazione dell’Anno geofisico internazionale – l’AGI, in programma dal 1957 al 1958, prorogato fino al 1959, Dobson decise di partire per lavorare nel continente antartico. Tra le misurazioni giornaliere, concordava con quella precedentemente verificata nell’emisfero settentrionale: la variazione oraria è sorprendente e non può essere utilizzata senza la realizzazione di somme orarie e medie. Registrò anche valori di 125UD al Polo Sud presso la stazione americana di Amundsen-Scott , mentre i francesi a Dumont d’Urville sulla costa antartica registrarono valori simili, come ad esempio quelli di Halley Bay . Pertanto, con le banche dati formate, comprese le misurazioni utilizzando la fase di Luna piena, è stato verificato che il conteggio dell’ozono dei periodi stagionali presentava una variazione significativa, con una grande perdita durante l’inverno e il recupero solo alla fine della primavera. Nel suo libro e articolo, Dobson ha riferito che le anomalie dell’ozono rispetto all’Antartide erano naturali. Dobson non ha mai usato il termine “buco”, sebbene queste anomalie sull’Antartide siano più espressive di quelle osservate nell’emisfero settentrionale (DOBSON, 1968a, 1968b). La variazione stagionale dell’ozono sull’Antartide è risultata molto più elevata in inverno, data l’assenza di luce solare (Fig. 4.2.2). Tuttavia, mentre la notte polare segna in modo significativo i mesi centrali dell’anno, con la presenza del Sole, l’incidenza dell’energia è vigorosa, presentando un equilibrio maggiore della parte equatoriale in energia ricevuta in 24 ore (Fig.4.2.2) raggiungendo il segno di 1.400 MJ.m-2 (KING e TURNER, 1997).

|

Fig.4.2.1 : La misurazione triennale dell’Anno Geofisico Internazionale. Le file complete sono misurazioni dell’ozono nell’emisfero settentrionale, a Spitzbergen , in Norvegia (78º45 “N 016º00” E). Notare i valori bassi durante i mesi invernali. Punti e pallini trapelati sono misurazioni dell’ozono a Halley Bay , in Antartide, durante lo stesso periodo. Nota i bassi valori di ozono nella primavera meridionale e quanto velocemente crescono a novembre, in un momento in cui la stratosfera si sta riscaldando. Notare anche il modello invertito tra gli emisferi, che dimostra la necessità della presenza di radiazione solare per la formazione di ozono. I granuli fuoriusciti vengono misurati nelle fasi lunari dell’Antartide (fonte: DOBSON, 1968a, p.401). |

|

Fig.4.2.2 : Somma della radiazione solare mensile media globale nelle stazioni dell’Antartide. Linea continua, dati dalla stazione di Faraday britannica (Base “F” 65 ° 15 “S 064 ° 16” W) dal 1963 al 1982; linea tratteggiata, dati dalla stazione britannica di Halley (75 ° 35 “S 026 ° 34” W nel 2001, mentre Halley “Z” V si muove mentre sposta la piattaforma del ghiaccio di Brunt ) dal 1963 al 1982; e linea tratteggiata, dati dalla stazione russa Vostok (78º27 “S 106º50” E) dal 1963 al 1973 (fonte: KING e TURNER, 1997, p. |

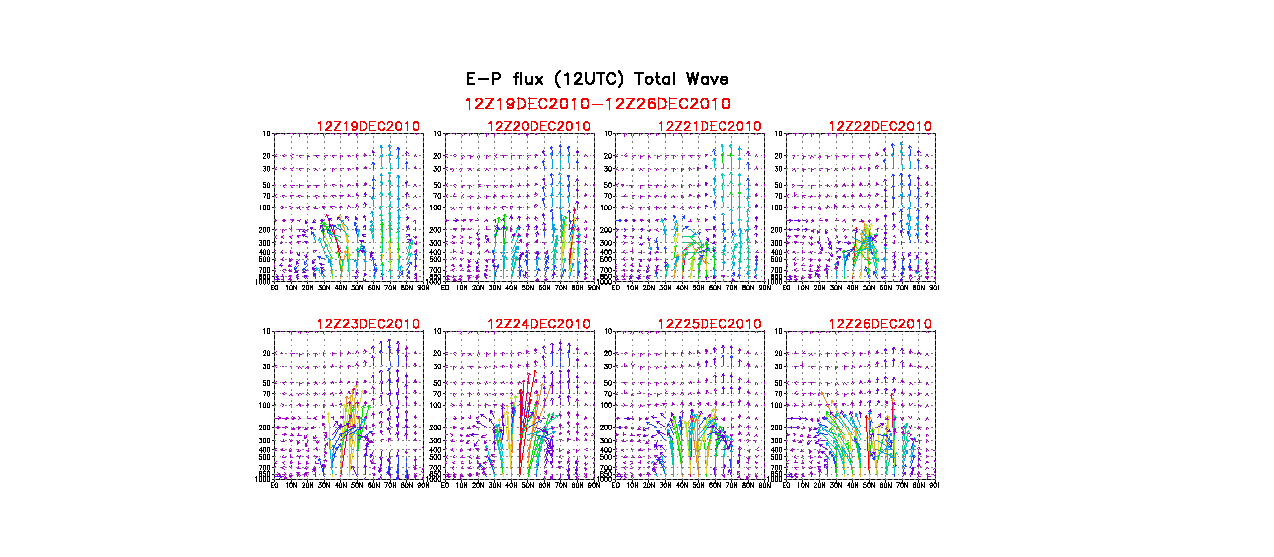

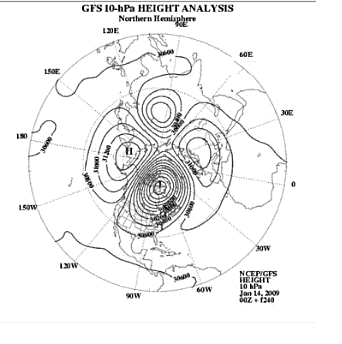

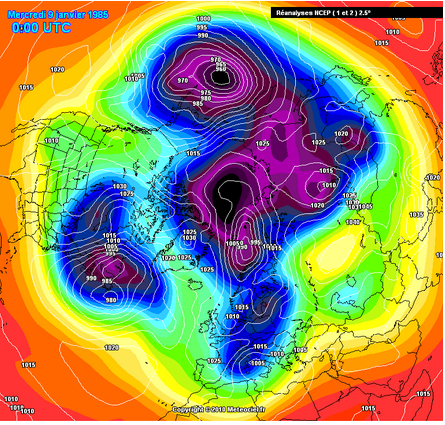

È anche importante sottolineare che durante il periodo invernale, a causa di un problema geometrico, la radiazione solare, anche in modo obliquo nella stratosfera, non è sufficiente a fornire la radiazione UV C per la formazione di ozono, proprio perché l’atmosfera intercetta questa radiazione in latitudini inferiori, consentendo solo il passaggio della radiazione infrarossa, che non viene utilizzata per la fotodiscitation, ma solo per il riscaldamento parziale della stratosfera durante l’inverno antartico. Pertanto, senza la radiazione UV C, non vi è alcun rinnovo dell’ozono, quindi durante l’inverno polare si prevede che la concentrazione di questo gas diminuisca bruscamente. Alleati a questo, i flussi di getto intorno all’Antartide isolano la base stratosferica polare della stratosfera a media latitudine, rendendo difficile lo scambio di aria rarefatta superiore, dove a bassa latitudine si ha una maggiore concentrazione di ozono, a differenza dell’alta latitudine, carente in inverno. Tuttavia, con l’arrivo della primavera, la situazione si stabilizza e le concentrazioni aumentano fino all’estate australe (Fig.4.2.3A a D). Non c’è da meravigliarsi se il vanto di tale anomalia si verifica a settembre, quando la differenza della parte polare rispetto alla parte delle latitudini medie è molto evidente. In anni di minimo solare, le concentrazioni sono basse sull’Antartico, ma non dovrebbero essere considerate allarmanti, ma piuttosto relative al loro ciclo naturale, cioè, sono anomalie della presunta normalità. Questa marcata differenza di ampia anomalia invernale differisce da quella dell’emisfero settentrionale.

Fig.4.2.3A a D : esempi di planisferi creati con dati medi dell’ozono, ottenuti mediante telerilevamento tramite lo spettrometro di mappatura dell’ozono totale – TOMS, nell’anno 2000. Si noti che mentre i mesi primaverili attraversano l’estate (A a D), c’è un aumento significativo dell’ozono medio sull’Antartide e, generalmente, nell’emisfero australe.E curiosamente, l’informazione dall’emisfero settentrionale è stata omessa quando a dicembre, passa attraverso il suo periodo invernale, dove le anomalie negative compaiono anche nel calcolo di ozono (Fonte: NASA, 2000).

.

Creare un’ipotesi fraudolenta.

È chiaro che le anomalie dell’ozono sono sempre state conosciute e che sono naturali. Era anche chiaro che le anomalie sono differenziate tra l’Artico e l’Antartico e sono stati condotti studi per comprendere e descrivere tali fenomeni, compresa la loro geometria. In questo modo, con l’avvento dell’era dei satelliti, sono stati creati diversi esperimenti di misurazione, teorie e procedure per essere in grado di rilevare da remoto una vasta gamma di fenomeni, molti dei quali, ovviamente, per scopi militari. Questi includono la misura passiva dell’ozono usando lo spettrometro di mappatura dell’ozono totale – TOMS, o spettrometro di mappatura dell’ozono totale . Questo lavoro è stato eseguito dal satellite Nimbus 7 , lanciato nel 1978, due anni dopo la morte di Dobson. Il Nimbus 7 era un satellite in orbita polare che passava in rassegna l’atmosfera terrestre con il suo TOMS incorporato, usando un complicato processo teorico in cui due radiometri venivano usati per bilanciare, il che alla fine generò una media. Queste medie dissimulano o attenuano l’informazione di alti e bassi, così importante nel calcolo dell’ozono e per la sua comprensione.

Ciò che seguì fu un completo allarmismo globale, in cui la frase “buchi nello strato di ozono”, coniata per la prima volta da R. Penndorf nel 1950, ma poi figurativamente, in modo impreciso e occasionale, divenne famosa dopo JB Farman , del British Antarctic Survey – BAS, ha pubblicato un articolo sulla rivista Nature nel 1985, utilizzando le informazioni di Nimbus 7 che stava assemblando una serie di dati dal 1979, chiudendola solo nel 1992. Farman ha usato i dati mensili dal 1980 al 1984, ottenuti dallo spettrometro TOMS per trarne le conclusioni. Ha trovato basse concentrazioni di ozono. Finora, nessuna notizia dopo aver controllato i lavori passati. Nota allora che sapeva già molto bene cosa avrebbe trovato, una significativa anomalia dell’ozono tra settembre e ottobre. Inoltre, sapeva anche che nel corso degli anni l’anomalia avrebbe avuto buone probabilità di essere più negativa, cioè di presentare una minore concentrazione di ozono sull’Antartide.

Ci sono informazioni precedenti che ci permettono di ricostituire queste affermazioni. Il primo dei quali, nel 1974, Molina e Rowland ha iniziato a evocare un problema di ozono, dovuto in particolare a una famiglia di sostanze contenenti cloro nella loro composizione. Solo tre anni dopo, nel 1977, a un anno dalla morte di Dobson, gli Stati Uniti vietarono l’uso di clorofluorocarburi (CFC) in aerosol non essenziali, e altri paesi come Canada, Norvegia e Svezia stavano riducendo la produzione e l’uso . Nello stesso anno iniziarono a formarsi alcune commissioni. Nel marzo 1985, in particolare, dopo la “segnalazione” di Farman, la Convenzione di Vienna stabilì il Protocollo di Montreal, che gestiva il mondo dietro ai firmatari. Nel 1987, la NASA è stata responsabile della creazione del primo pannello “scientifico” al mondo per risolvere un “problema”: Ozone Trends Panel – OTP, che è stato creato per supportare legittimità) per le decisioni politiche che sono state prese. Questo stesso pannello ha pubblicato nel 1988 che lo “strato di ozono” negli Stati Uniti e in Europa era diminuito di circa il 3% tra il 1969 e il 1986. Questi studi sono stati tenuti segreti e non sono stati pubblicati fino a due anni dopo ( FERREYRA, 2006). Curiosamente, hanno iniziato un anno dopo la chiusura della ricerca di Dobson, che ha funzionato con la misurazione dell’ozono dal 1928 al 1968 senza interruzioni (DOBSON, 1968a, 1968b).

In effetti, le informazioni scientifiche disponibili e pubblicate sulla rivista Science il 12 febbraio 1988 da J. Scotto del ramo biostatico del National Cancer Institute , hanno presentato forti prove scientifiche che la quantità di Le radiazioni UV B che raggiungevano la superficie negli Stati Uniti non solo non erano aumentate, ma erano anche diminuite del 7% tra il 1974 e il 1985. Questi studi, che erano completamente ignorati dai media internazionali, erano basati su una rete di monitoraggio della superficie che ha registrato le radiazioni ultraviolette quotidiane dal 1974 da Robertson-Berger . Secondo lo stesso Scotto:

” I record annuali UV UV B ottenuti durante periodi consecutivi di sei anni (dal 1974 al 1979 e dal 1980 al 1985) mostrano un cambiamento negativo in ogni stagione, con diminuzioni che variano dal 2 al 7% (…) mostrano che non c’è una tendenza positiva nelle letture annuali UV B per il 1974 fino al 1985 (…) La variazione della media annuale stimata variava dal -1,1% a Minneapolis , Minnesota ; a -4,0% a Philadelphia, in Pennsylvania. Per tutte le stagioni, le letture dei raggi UV B sono diminuite dello 0,7% all’anno dal 1974. “(Fonte: SCOTTO et al ., 1988, p.762).

Oltre a Scotto, molti altri scienziati all’epoca stavano registrando una diminuzione dell’incidenza delle radiazioni ultraviolette che raggiungevano la superficie terrestre. Ha inoltre respinto in un altro articolo di Science la possibilità che la contaminazione dell’aria urbana potesse disperdere la radiazione UV B, causando l’effettiva riduzione della radiazione UV B alla superficie. Ha anche ricordato le informazioni dalla stazione di misurazione sull’isola vulcanica di Mauna Loa, nelle Hawaii, che misura l’anidride carbonica, “teoricamente” priva di contaminazione dell’aria, dove le analisi preliminari condotte non hanno mostrato alcun aumento dell’incidenza di Radiazione UV B tra il 1974 e il 1985 (FERREYRA, 2006). Prendendo in considerazione la spiegazione precedente, se una minore quantità di radiazione UV B raggiungesse la superficie, significherebbe che c’era un equilibrio positivo nella produzione di ozono stratosferico nei periodi menzionati (Fig.4.3.1).

Dopo questo fatto di “ribellione” scientifica, prendiamo nota di ciò che l’ establishment scientifico mondiale ha preparato per la voce dissenziente. Scotto non è stato in grado di continuare la sua ricerca dopo il 1985 perché i fondi per il finanziamento della maggior parte delle stazioni di monitoraggio della radiazione UV B sono stati cancellati e le stazioni, che erano ancora i resti dell’AGI, sono state chiuse. Lo stesso Scotto, uno specialista del cancro di fama mondiale, non ha ricevuto ulteriori sussidi per recarsi a congressi internazionali per presentare le sue scoperte sulla riduzione dell’incidenza delle radiazioni UV B inserendo il cosiddetto “cono d’ombra” progettato dalla potente lobby politica di Ecologia Internazionale, qualcosa di molto comune tra gli attuali scienziati climatici che non rimangono in silenzio davanti alla pseudoscienza dominante del “riscaldamento globale antropico” e dei “cambiamenti climatici”. Le voci degli scienziati che lavorano con la misurazione diretta dell’ozono sono state categoricamente silenziate (FERREYRA, 2006). Le stazioni furono chiuse solo perché le informazioni raccolte indicavano una situazione che non corroborava ciò che era politicamente ed economicamente necessario per vantarsi in quel momento: l’idea allarmistica che l’ozono si sarebbe assottigliato.

|

Fig.4.3.1 : serie di dati di diverse stazioni situate negli Stati Uniti d’America, dal 1974 al 1985. Il conteggio totale delle radiazioni ultraviolette B ha mostrato una riduzione nel corso degli anni, indicando chiaramente che ha aumentato la produzione di ozono, non al contrario, come annunciato dai media del tempo e da altri impegnati nella causa (Fonte: SCOTTO et al ., 1988). |

Con il campo aperto e privo di ostacoli, Molina e Rowland hanno sollevato la questione, proprio quando la produzione di gas CFC ha raggiunto un milione di tonnellate all’anno, principalmente per soddisfare i paesi in via di sviluppo. Poiché entrambi non capivano l’atmosfera, come ci si poteva aspettare, con il loro lavoro passato per “l’era nucleare”, si consultarono con alcuni esperti di dinamiche atmosferiche e conclusero che i CFC rilasciati sulla Terra tendono ad essere dispersi dai venti in tutta l’atmosfera, indipendentemente da dove sono stati emessi ( FERREYRA). Tuttavia, è sufficiente eseguire un piccolo calcolo per vedere che i gas CFC, come Freon -11®, con peso molecolare 137,51 e Freon -12®, con 121.01, sono 4,66 e 4,10 tempi più pesanti dell’aria e che gli stessi gas siano 2.46 e 2.16 volte più pesanti del ferro. In questo modo, non è mai stato spiegato come questi gas, solitamente scartati in ambienti controllati, più pesanti dell’aria, possano viaggiare attraverso l’atmosfera in quantità eccezionali. Tendono a scendere ai livelli più bassi della troposfera e possono anche circolare all’interno dei fenomeni per un certo periodo, ma in un dato momento, alla fine, si stabiliranno, specialmente sugli oceani. Quindi, poiché sono troppo pesanti, i CFC antropogenici non salgono nella stratosfera. Notare la differenza tra questo processo di rilascio umano, che si verifica sulla superficie, e quello dei vulcani, che rilasciano i gas altamente energizzati e riscaldati nella stratosfera. Così, Molina e Rowland lanciano la prima ipotesi antropica per l’emergere del cloro nella stratosfera, come il grande cattivo del cosiddetto “buco dell’ozono”. I gas umani CFC, anche altamente stabili e non reattivi, in presenza della radiazione UV C, che si verifica nella parte più centrale e più alta della stratosfera, verrebbero interrotti, causando quello che chiamavano il “ciclo catalitico del cloro”:

Si noti che nel passaggio gli atomi di cloro rilasciati sono estremamente reattivi e devono scegliere le molecole di ozono per produrre il monossido di cloro del passaggio, anche se è altamente improbabile che ciò accada. Inoltre, il monossido di cloro avrebbe ancora bisogno di trovare un ossigeno atomico rilasciato per eseguire il passaggio . Hanno inoltre affermato che un solo atomo privo di cloro sarebbe responsabile della distruzione di 100 (cento) migliaia di molecole di ozono. È interessante notare che hanno ancora affermato che il biossido di azoto (NO2), essendo uno dei molti gas atmosferici, potrebbe “dirottare” il cloro , producendo nitrato di cloro (ClNO3). Questa reazione è stata definita una “reazione di interferenza”. Ne consegue che non sono mai state trovate molecole di CFC sufficienti nei campioni di stratosfera che potrebbero avere alcun significato per tali reazioni catalitiche del cloro. Ciò che è stato dimostrato in tali campioni è che ci sono molti altri gas, come l’idrogeno, l’elio, il metano, il monossido di cloro, il biossido di cloro, tutti gli ossidi di azoto, nonché diverse famiglie di gas con bromo, fluoro, iodio, in aggiunta di anidride carbonica e tutti i nobili. Inoltre, la necessità della radiazione UV C sceglie il CFC come un grande galleggiante, il che non lo è, poiché le radiazioni di questa banda si verificano a circa 40 km di altitudine, dove l’ossigeno e l’azoto sono gli eletti ad arrivare (MADURO e SCHAUERHAMMER, 1992). In effetti, l’ipotesi chimica di Molina nell’ambiente naturale sarebbe impossibile da verificarsi, poiché richiede calore per il suo verificarsi. Ad alta quota della stratosfera sul polo sud, le temperature raggiungono -82,0 ° C nella notte polare. Quindi, mentre le magiche reazioni chimiche di Molina richiedono calore, l’ozono, da solo, reagisce con un’altra molecola, senza particolari esigenze. L’assenza di ozono nella stratosfera non può essere associata al cloro, ma piuttosto alla nullità che le molecole di ozono producono mediante intercettazione, insieme alla completa mancanza di radiazione UV C che farebbe rinnovamento dell’ozono, derivato dall’ossigeno molecolare.

Il problema va oltre. C’è il fatto che le caratteristiche estremamente particolari richieste per l’esaurimento dell’ozono sono possibili solo sul nucleo antartico entro circa tre o quattro settimane dopo la metà di settembre. Curiosamente, e mai divulgati dai media internazionali, in questo stesso periodo ci sono anche molte assenze di altri gas nell’alta stratosfera e che dovrebbero essere opportunamente chiamati anche “buchi”. Questi sarebbero i casi del “foro dell’ossido di azoto”, “foro del vapore acqueo”, non a caso gas derivati dalle maggioranze nell’atmosfera, dove il vapore acqueo, come sostanza variabile, può entrare nell’atmosfera fino al 4%, superando qualsiasi altro gas, tranne i due principali, N2 e O2 (FERREYRA, 2006).

Non soddisfatta, Molina, da sempre assistente di Rowland, insiste ancora su un’ipotesi chimica incredibilmente complessa che definisce chimica “eterogenica” o “dimera” dove le temperature dovrebbero essere estremamente basse, sotto i -78,0 ° C. Questa situazione, come visto in precedenza, può verificarsi, in una remota possibilità, quando il Sole “ritorna” nell’emisfero australe, nelle prime settimane di settembre; queste sarebbero quindi le condizioni ideali per l’esaurimento dell’ozono per subire una nuova e più intricata combinazione di reazioni chimiche che esisterebbe solo nel mondo fantastico di Molina. Vediamo perché:

Quindi, Eberstein giustamente critica:

Non esiste un meccanismo che giustifichi la creazione del “buco dell’ozono”. Questo è un enorme difetto. Se qualcuno ha una teoria, dovrebbe essere in grado di fornire un meccanismo definitivo. Altrimenti, è solo speculazione. Questo problema della riduzione dell’ozono in Antartide deve essere messo su basi scientifiche più solide. “(Fonte: EBERSTEIN, Geophysical Research Letters , maggio 1990).

C’era di più. Dopo una serie di esperimenti di laboratorio estremamente complessi, Lawrence, Clemitshaw e Apkarian (1990) arrivarono a una conclusione sulle ipotesi di Molina:

Nell’intervallo spettrale riportato di recente, in cui il ClOO passerebbe attraverso una dissociazione monomolecolare per produrre Cl + O2 (…) abbiamo condotto studi per stabilire che se un tale canale di foto-dissociazione esiste realmente, allora la sua resa quantica è inferiore a 5 × 10 -4, un processo con una prestazione quantica così piccola sarebbe irrilevante per la fotochimica ClOO nella distruzione dell’ozono stratosferico. (Fonte: LAWRENCE, CLEMITSHAW, APKARIAN, Journal of Geophysical Research , 10/20/1990).

Infine, la luce del sole, che era così necessaria per l’ipotesi “dimera” chimica di Molina, come il grande innesco per l’emergere del “foro nello strato di ozono” massimizzato all’ingresso della primavera fu nuovamente rovesciato dalla Natura, che insiste nel non seguire le regole umane. I satelliti in orbita polare della National Oceanic and Atmospheric Administration (NOAA), o National Oceanic and Atmospheric Administration , hanno rilevato che l’apparizione della massima anomalia dell’ozono si è verificata per un intero mese prima della comparsa del Sole. Quindi, le anomalie sarebbero state molto ben sviluppate prima quella luce solare e la sua radiazione UV-C erano nella stratosfera, e questo è esattamente l’opposto dell’ipotesi “precedente” di Molina. Quindi, se si verificano reazioni chimiche per creare l’anomalia dell’ozono nella stratosfera, queste reazioni si verificherebbero nella piena oscurità, il che di per sé invalida completamente l’ipotesi, quindi deve essere scartata (FERREYRA, 2006).

Quindi, anche se non fosse possibile riprodurre l’ipotesi in laboratorio, come sarebbe possibile farlo nella stratosfera antartica? Inoltre, è stato verificato che la notte polare presentava temperature estremamente basse, non permettendo che l’energia fosse fornita alle reazioni suggestionabili (Fig.4.3.2). Questo ha dimostrato che se le reazioni si verificano per la diminuzione dell’ozono, si verificano dai loro stessi shock. Il recupero dell’ozonosfera avviene naturalmente con l’arrivo della luce solare, rinnovando la rapida azione di scambio tra l’ossigeno molecolare e lo stadio transitorio dell’ozono. Con la presenza del Sole, le temperature della stratosfera sono molto alte, data l’incidenza permanente di radiazioni. Così, ancora una volta, a temperature elevate, la teoria di Molina fallì, poiché non ci sono temperature inferiori a -78,0 ° C per tutto il periodo in cui il Sole è apparente (Fig. Di nuovo, l’ipotesi che queste condizioni siano stabilite nella stratosfera antartica è partita per il mondo surreale (KING e TURNER, 1997).

|

Fig.4.3.2 : Profilo di temperatura sulla stazione russa di Vostok (78º27 “S 106º50” E) nel luglio 1989, piena notte invernale polare. C’era una forte inversione della temperatura più vicina alla superficie. La linea completa indica il profilo della temperatura media. Notare le bassissime temperature della stratosfera, dove la pressione è inferiore a 150mb, rendendo impossibile l’energia per l’ipotesi Molina (Fonte: KING e TURNER, 1997, p.86). |

|

Fig.4.3.3 : Profilo di temperatura media sulla stazione di Halley britannica (75º30 “S 026º20” E, nel 1996) a luglio e gennaio, con dati del periodo dal 1957 al 1993. Si noti che in alta quota, alla base del stratosfera, anche ad una latitudine più bassa, le temperature sono molto basse in inverno per i mesi di luglio, ma aumentano significativamente in estate per i mesi di gennaio (Fonte: adattamento di FELICIO de KING e TURNER, 1997, p.88) . |

Cloro naturale X antropico

E da dove è arrivata la CFC in questa storia? Come il presunto fornitore di cloro libero nella stratosfera. L’indagine diventa sorprendente quando si esaminano le fonti di cloro per l’atmosfera e le sue scale. Pertanto, si ritiene che sia stato molto finto pensare che il raro lancio di un gas magro nell’atmosfera avrebbe potuto, in meno di 50 anni, essere distrutto in un tale “strato di ozono”, qualcosa che non esiste nemmeno. Come, ad esempio, potrebbero pensare che la produzione di cloro, presumibilmente dai CFC, abbia superato la produzione di oceani e vulcani? Diamo un’occhiata agli ordini scalari e ad alcuni processi. Se i CFC potessero produrre al massimo 7,500 tonnellate all’anno al loro picco di produzione, solo il biota oceanico rilascia 5 (cinque) milioni di tonnellate di cloro; gli incendi boschivi aggiungono altri 9 (nove) milioni di tonnellate; i vulcani del mondo contribuiscono 36 (trentasei) milioni di tonnellate e infine, la stragrande maggioranza, gli oceani aggiungono 600 (seicento) milioni di tonnellate di cloro (Fig.4.4.1). Pertanto, la quantità di cloro naturale rilasciato nell’atmosfera supera di 80.000 volte i CFC incriminati. Non c’è da meravigliarsi se queste molecole di CFC non si trovano facilmente nell’atmosfera terrestre (MADURO e SCHAUERHAMMER, 1992).

|

Fig.4.4.1 : Schema pittorico delle fonti atmosferiche di cloro, in milioni di tonnellate, confrontato in scala con il cloro immagazzinato in CFC e il rilascio teorico di cloro nell’atmosfera da parte degli stessi composti (Fonte: Adattamento di Félicio de Maduro e Schauerhammer, 1992 ). |

La maggior parte del cloro nell’atmosfera è indiscutibilmente dagli oceani, perché durante il processo di evaporazione, che è immenso alla superficie del mare, le molecole altamente energizzate finiscono per trasportare sali di cloruro di sodio, uno dei principali aerosol marini. Il NaCl è facilmente caricato dai processi convettivi perché è leggero e partecipa in particolare ai processi di nucleazione delle goccioline. Un fatto che attirò l’attenzione fu la notizia che i telescopi terrestri ad alta definizione venivano calibrati dai fasci pulsanti di LASER, che ionizzava gli atomi (Na) liberi di sodio nella ionosfera, per simulare le stelle. La domanda che dovrebbe essere posta è: come è arrivato il sodio? Se troviamo che il cloruro di sodio potrebbe anche essere fotodissociato dall’UV C, avremmo un atomo di sodio libero e, categoricamente, anche il cloro libero.

Oltre agli oceani, abbiamo i vulcani. In Antartide, in particolare, il Monte Erebus , a un’altitudine di 3.794 metri sull’isola di Ross e attivo dalla data della sua scoperta nel 1841, rilascia circa 1.200 tonnellate al giorno di gas cloridrico (HCl) e 500 tonnellate al giorno di gas fluoridrico (HF) continuamente perché è un tipo a vapore. Poiché la troposfera è molto superficiale e la stratosfera diventa molto bassa a questa latitudine, specialmente durante l’inverno, solo il Monte Erebus rilascia 438.000 tonnellate di cloro all’anno direttamente nella fascia in cui si formerebbe l’ozono. Si noti che oltre all’elevata quantità di cloro, abbiamo ancora il lancio di 182.500 tonnellate di fluoro, più attivo persino del cloro stesso. Confrontando questi valori con il lancio annuale della stagione CFC di 7.500 tonnellate all’anno, si è riscontrato che solo Erebus copre la “fornitura” umana di cloro di circa 58,4 volte, cioè meno di uno settimana il vulcano avrebbe già rilasciato tutta la produzione umana annuale di gas CFC nell’atmosfera (MADURO e SCHAUERHAMMER, 1992). Ferreyra ha anche ricordato le tre campagne condotte dal Dr. Haroun Tazieff al vertice del Monte Erebus per studiare i gas liberati, dove ha dimostrato le quantità specificate, principalmente a causa della cura delle circolazioni sottovento verso la stazione statunitense McMurdo , che si trova vicino vulcano. Considerando che questo fatto era noto, Susan Solomon, un membro dell’OTP, eseguì palloni con sensore di cloro vicino alla stazione di McMurdo Sound e, naturalmente, “dimenticò” che il Monte Erebus si trovava nelle vicinanze. Né menzionò che i palloncini, quando gettati nel vento “favorevole” al sopravvento al Monte Erebus , entrarono nei pennacchi di gas lanciati dal vulcano, con le loro centinaia di tonnellate di HCl al giorno, che, in una troposfera estremamente secca, dato l’altitudine, hanno molte possibilità di rimanere più a lungo rispetto alle regioni tropicali. Convenientemente, ha anche dimenticato che la tropopausa a quelle fermate di solito si verifica molto più in basso. Quindi, i gas riscaldati attraverserebbero rapidamente questo strato e raggiungerebbero la base della stratosfera, che può essere alta circa 6 km. Quando il dott. Tazieff attirò l’attenzione sul contributo di Mount Erebus , lo ignorarono semplicemente, perché dopotutto, come Lino sottolineò, che cosa deve fare un vulcanologo a una domanda trascendentale? (MADURO e SCHAUERHAMMER, 1992).

Quindi, se c’è una presunta alta presenza di cloro nell’atmosfera antartica, potrebbe essere solo di origine naturale. Non avrebbe mai dovuto accettare che il 90% dei CFC che erano stati rilasciati nel mondo potessero viaggiare nella stratosfera antartica e venire fotodisocializzati lì, specialmente quando la maggior parte di questi gas veniva prodotta nell’emisfero settentrionale. Infatti, un certo numero di fattori importanti, come il cloro naturale proveniente da una varietà di fonti, sono stati deliberatamente trascurati , il che avrebbe invalidato i commenti di un regista di Du Pont ® al momento sostenendo che il 95% del cloro trovato in Antartide era di origine antropogenica (SAGAN, 1998).

Si può andare oltre? Sì, quando i vari gas che fanno parte delle grandi famiglie di CFC, i cosiddetti organofluorocarburi o anche gli alocarburi, sono stati studiati in letteratura, molti di essi fanno parte di cicli naturali come la “esplosione di bromo” (CHBr3) di cui l’origine è legata alle alghe. In aggiunta a ciò, le varie reazioni che si verificano nella neve e nel ghiaccio stesso quando sono appena precipitate e non maturate sotto forma di ghiaccio permanente e il CH3Cl appena scoperto, la cui fonte sarebbe piante tropicali e materiale vegetale in decomposizione, di cui ancora non si sa nulla ( TOMASONI, 2011, apud GEBHARDT, 2008). È stato notato che gli alocarburi hanno fonti naturali che non possono essere ignorate, anche se possono sembrare una grande sorpresa, sono state trovate nelle emissioni di Vulcano , in Italia e misurate direttamente. Le concentrazioni andavano da parti per trilione – pptv a parti per milione – ppmv. Tra i gas trovati abbiamo CH3Br3, CH3Cl, CH3I, C2H5Br, oltre al benzene-clorurato, oltre allo stesso CFC, Freon -11®. (Schwandner et al ., 2004). Tuttavia, altri ricercatori come Lutgen, Khalil e Rasmussen hanno dimostrato che la maggior parte dei CFC, poiché sono gas pesanti, come spiegato in precedenza, si depositano nel suolo e negli oceani e servono da cibo per i batteri. Nel caso degli oceani, possono ancora essere dissolti dall’acqua marina (LUDGEN, 2006). È anche noto dalla letteratura che ci sono batteri che vivono nei crateri vulcanici o negli sbocchi dei vulcani sottomarini, che consumano quantità estremamente elevate di zolfo, che sarebbe considerato tossico per altri esseri viventi, così come lieviti neri che si nutrono di sostanze estremamente diverse, come olio, benzene e altri prodotti altamente tossici. Altri esempi possono ancora essere elencati, come il microrganismo della specie Emiliania huxleyi , che vive in alte concentrazioni di anidride carbonica, nel caso in cui gli oceani potessero tenerlo, dove poi lo consumerebbero. Quindi, questi esseri viventi si sono adattati solo negli ultimi 60 anni all’apprendimento a mangiare i CFC, in particolare il Freon- 11®? Certo che no. Tali esseri viventi sono già stati adattati a questo per migliaia di anni, forse anche di più, così che ancora una volta la Natura ha presentato i suoi meccanismi di autoregolamentazione. Quindi, probabilmente dagli studi sui gas emessi dai vulcani, gli specialisti hanno trovato applicazioni specifiche per le caratteristiche dei materiali alogeni e li hanno brevettati, non essendo una scoperta chimica artificiale in particolare, ma qualcosa trovato o adattato dalla natura stessa.

Va anche notato che molti altri gas naturali, che rappresentano una porzione infinitamente maggiore dei gas di traccia, come NO2, CO2 e H2O, questi ultimi nel loro vapore acqueo formano fino al 4%, sono anche fotodistrati quando raggiungono la stratosfera o talvolta quando sono correlati alle attività elettriche del fulmine. La sua fonte principale è di nuovo gli oceani e i vulcani, che possono generare monossido di azoto (NO), monossido di carbonio (CO), ossigeno atomico (O “), radicale idrossile (OH) e idrogeno libero (H).

. CONCLUSIONE

In questo primo volume intendevamo dimostrare i fatti principali riguardanti la fisica e la chimica della formazione dell’ozonosfera altamente variabile, le fonti di cloro, la geometria della radiazione incidente e i lavori di lunga data sulla misurazione dell’ozono e la sua variazione, molto noti. È stato anche dimostrato che l’ipotesi antropica come fonte di cloro è totalmente fragile, specialmente contro le fonti naturali di cloro.

Nel corso della storia del lavoro, è stato dimostrato che l’atteggiamento scientifico nei confronti delle questioni relative all’ozono cambia. Lo spostamento di messa a fuoco da due diversi periodi è stato chiaro: dall’inizio del ventesimo secolo fino alla morte di Gordon Dobson e poi in sequenza, l’uso del satellite Nimbus 7 fino ai giorni nostri, con l’ambientalismo che guida le decisioni mondiali.

Viene nuovamente sottolineato che nella controversia sull’uso del satellite Nimbus 7 , sapevano esattamente cosa avrebbero trovato: un’anomalia dell’ozono sull’Antartide. Nel caso della stratosfera, la stessa cosa, cioè la presenza di cloro, ma in effetti, se fosse originata dai CFC, non è mai stata dimostrata . Un’assurda ipotesi fisico-chimica, che era difficile da eseguire in laboratorio, era necessaria in aggiunta alla presenza di cloro nell’atmosfera, misurata solo in Antartide, per corroborare la trasformazione dell’ipotesi fraudolenta in una teoria. Questo è stato un esempio della completa distorsione del metodo scientifico consacrato.

REFERÊNCIAS

DOBSON, G.M.B. (a) Forty years’ research on atmospheric ozone at oxford: a history. In: Applied Optics, Vol. 7, nº 3, março p.387-405, 1968.

(b) Exploring the atmosphere. Oxford University Press, Londres, Inglaterra, 1968.

EBERSTEIN, I. J. Photodissociation of Cl2O2 in the spring Antarctic lower stratosphere. In: Geophysical Research Letters, Vol. 17, (6) maio, p.721-724, 1990.

FERREYRA, E. El fraude del ozonio. In: Ecologia: mitos y fraudes, FAEC, México, Cap. 2, 2006.

KING, J. C. e TURNER, J. Antarctic meteorology and climatology, Cambridge Atmospheric and Space Science Series, Cambridge, Inglaterra, Cap. 1 e 2, 1997.

LAWRENCE, W. G., CLEMITSHAW, K. C. e APKARIAN, V. A. On the relevance of OClO photodissociation to the destruction of stratospheric ozone. In: Journal of Geophysical Research, Vol. 95 (D11):18, 20/outubro, p.591-595, 1990.

LUTGEN, P. El Agujero de Ozono se Cierra. 2006. Disponível em <http://www.mitosyfraudes.org/Ozo/OzonoLutgen.html> Acesso em 30 de julho de 2012.

Articolo originale qui https://fakeclimate.files.wordpress.com/2013/03/tupa2012-ricardo340-674-1-sm.pdf

SAND-RIO